2 첫 도전 t-test

2.1 멀고도 먼 길의 시작

2.1.1 t-test란 무엇일까?

축하합니다!! 이제 여러분들은 통계다운 통계를 시작하게 되었습니다. 아마 모든 통계책의 가장 앞쪽에 등장하는 통계적인 방법이 바로 이 t-test일 것입니다. 우리말로는 t-검정이라고 합니다. 솔직히, t-검정은 공식도 비교적 단순하고 쉬워 보입니다. 그래서 굳이 자세하게 가르치지도 않지만 학생들도 굳이 꼬치꼬치 캐묻지 않는 대상입니다. 그러나 여기에 중요한 것이 있습니다. t-검정의 공식을 암기하고 문제를 풀어 정답을 맞히는 것보다 더 중요한 것은 바로 이 t-검정의 근본을 이해하는 것입니다. 이를 제대로 알고 간다면 이후에 등장할 분산분석 (ANOVA: Analysis of Variance)도 쉽게 이해될 수 있습니다. 그러나 이를 그냥 암기하고 넘어간다면 앞으로 등장할 통계가 어렵게만 느껴질 것입니다.

위키 백과에서 t-test가 무엇인지 찾아보았습니다.

t-테스트(t-test) 또는 t-검정은 검정하는 통계량이 귀무가설 하에서 t-분포를 따르는 통계적 가설 검정이다. t-검정은 검정 통계량의 스케일링 항 값이 알려진 경우 검정하는 통계량이 정규 분포를 따르는 경우에 가장 일반적으로 적용된다. 이 경우 모집단의 분산과 같은 스케일링 항을 알 수 없으나 이를 데이터를 기반으로 한 추정 값으로 대체하면 테스트 통계는 t-분포를 따른다.

알 수 없는 말들이 많지요? 아마 어떤 통계책을 찾아보아도 비슷할 것입니다. 이렇게 설명해서는 도대체 알 수가 없습니다. 사실 그 이름부터가 도대체 알 수 가 없습니다. 여러분들이 새로운 통계방법을 공부할 때, 가장 중요한 것 몇 가지를 알려드리겠습니다. 첫 번째는 이 방법의 목적이 무엇인지 명확히 알아야 합니다. 책에 나오는 정의 말고 본인의 말로 표현할 수 있어야 합니다. 두 번째는, 이 새로운 통계적 방법의 기본적인 맥락입니다. 물론 수학적 감각이 뛰어나다면 몇 가지 공식이나 수식을 통해서 빠르게 이해할 수 있습니다. 하지만, 우리 같은 초보들에게는 머나먼 일이지요. 하지만 그래도 기본적인 프로세스와 흐름 및 방법은 알고 있어야 합니다. 세 번째는 분석결과를 어떻게 해석해야 하는지 알아야 합니다. 마지막으로 모든 분석방법은 절대 완벽하지 않으므로 각 방법이 가진 주의사항을 알아야합니다. 그럼 이제 t-test로의 여행을 떠나 봅시다!!

2.1.2 이름이 왜 t-test일까?

t-test의 발원지(?)가 영국 더블린의 기네스 맥주 공장이라는 사실을 알고 계신가요?

여러 가지 설이 존재합니다만, 가장 많은 사람들이 신뢰하는 것은 바로 이 기네스공장입니다. 놀랍지요? 기네스 맥주는 아서 기네스란 사람의 이름을 따서 기네스란 이름이 됩니다. 아서 기네스는 잉글랜드 출신이었고 아일랜드에 정착을 하는데, 그러다보니 당시 잉글랜로서는 아일랜드 지배 강화를 위해 기네스를 우대합니다. 그런 이유인지는 모르겠으나 아서 기네스는 망한 양조장을 1년에 45파운드의 임대료를 내고 무려 9,000년간 임대를 하게 됩니다. 아직도 8000년 가까이 임대기간이 남아있다고 하니 정말 엄청나죠? 하여간 19세기 후반 기네스 맥주는 해가 지지 않는 대영제국의 위세를 타고 전 세계에 이름을 날리게 됩니다.

이 시기는 경영학에서도 과학적 관리기법이라는 것들이 등장하기 시작하는 시기이고 당연히 당시 영국은 이런 변화를 주도하는 국가였습니다. 이런 분위기 때문이었는지 기네스는 맥주 양조장으로선 처음으로 과학자를 영입합니다. 처음엔 옥스퍼드대 출신의 화학자 토머스 베넷 케이스를 영입합니다. 1893년에 입사한 그는 맥주의 품질은 홉에서 연질 수지가 차지하는 비율과 관련이 있다고 보고 연질수지의 양을 추정해보려고 당시에 주로 사용되던 대형표본이론을 적용해 150개 이상의 표본으로 연구를 진행하고 싶었지만 충분한 표본을 확보하지 못하고 양도 적어 어려움이 있었습니다. 어느 보리가 연질 수지가 많은지 혹은 연질 수지가 비슷해도 어떤 보리가 더 많이 생산되는지 실험할게 많았던 것이지요.

결국 맥주생산에 사용할 보리로 어떤 보리가 가장 좋은지 알아내려면 어마어마한 노력이 필요했습니다. 이 시기까지만 해도 아직 소규모의 표본으로 통계적 연구를 진행할 수 있는 이론적 기반이 없었던 것이지요. 이러한 이유로 연구가 지지부진할 때 기네스에 윌리엄 실리 고셋이 등장합니다. 고셋은 옥스퍼드에 입학하기 전에 윈체스터 대학을 다녔고 화학과 수학을 공부했으며 옥스퍼드를 졸업하고 더블린으로 건너가 기네스에서 일하기 시작합니다. 그가 연구한 분야는 기네스에서 가장 중요한 단일 성분인 보리의 수확량을 향상시키는 것이었습니다. 보리는 다른 작물과 마찬가지로 여러 가지 종류가 있는데 어떤 품종은 다른 것 보다 생산량이 더 많습니다. 같은 면적과 비슷한 조건에서 재배되었더라도 한 품종은 다른 것 보다 두 배의 생산량을 생산할 수도 있습니다. 이것은 복잡한 문제로 이어지는데요. 한 종류의 보리가 다른 것 보다 더 많이 생산된다면, 어떻게 합리적인 수준의 과학적 확실성을 결정할 수 있을지 문제가 되는 것이지요. 앞서 토머스 케이스가 어려워하던 문제가 바로 이것입니다.

하지만 1900년대 초에는, 통계가 오늘날과 같지 않았습니다. 가설 실험은 존재했지만 매우 작은 표본에 대한 원칙은 없었기 때문에 당시에는 실험에서 충분한 크기의 샘플을 얻기 위해서는 넓은 땅에 많은 종류의 보리를 엄청나게 많이 재배하는 것이 유일한 해결책이었습니다. 그러나 고셋에게 이것은 용납할 수 없는 일이었습니다. 시간도 많이 걸리지만 가설 검사를 위해 엄청난 양의 농작물을 재배하는 것은 낭비였기 때문이죠. 고셋은 통계학 지식을 활용하여 문제 해결에 착수합니다. 특히, 그는 표본이 작은 정규 분포 모집단의 평균을 추정할 때 발생하는 연속 확률 분포를 공식화했고 두 개의 표본이 주어진다면 표본 크기가 작더라도 한 표본의 평균이 다른 표본의 평균과 어떻게 같은지를 계산할 수 있게 됩니다. 이것이 바로 우리가 알고 있는 t-test입니다.

그런데 왜 이름이 이럴까요? 당시 기네스의 다른 직원이 신문에 글을 기고하다가 우연히 기네스의 영업 비밀을 누설하게 되었다고 합니다. 그래서 결국 기네스에서는 어떠한 유의 출판도 허용하지 않게 됩니다. 이 문제를 우회하기 위해 고셋은 본명대신 필명을 사용하여 회사의 눈을 피하기로 합니다. 혹자들은 기네스와 사전에 합의 되었다고도 하는데 그런 것 같지는 않습니다. 어쨌거나 그래서 윌리엄 고셋은 ’Student’란 필명으로 논문을 한편 쓰는데요. 이 논문에 등장한 테스트를 student test 혹은 student t-test라고 불렀습니다. 즉 student라는 단어의 마지막 t를 붙여 t-test라고 하는 것이지요. 만약 윌리업 고셋이 본인의 이름으로 출판을 했다면 아마도 고셋 테스트가 되었을 가능성이 컸을 겁니다.

Student. (1908). The probable error of a mean. Biometrika, 1-25.

바로 이 논문이 그 유명한 student의 t-test가 처음으로 세상에 빛을 보게 되는 그 논문입니다. 구글 스칼라에서 검색하셔도 되고 위의 링크를 따라 가셔도 보실 수 있습니다. 생각보다는 그리 어렵지 않은 영어로 되어 있습니다. 시간이 되신다면 읽어보셔도 좋겠습니다. 저는 너무 지루하고 어렵고 졸려서 포기했습니다.

2.1.3 t-test의 목적

앞에서 t-test의 이름이 왜 t-test가 되었는지 배경은 설명했습니다. 이 설명에 t-test의 목적 비슷한 것이 잠시 지나가기는 했습니다만, 이제 확실하게 t-test의 목적이 무엇인지 이야기 하겠습니다. 사실 정확하지는 않으나 시작단계에서는 이렇게 외워두십시요.

“t-test의 목적은 두 집단이 같은지 다른지 비교하기 위한 것이다.”

Figure 2.1 에 t-test의 목적을 그림으로 그려봤습니다. A와 B라는 두 집단 혹은 그룹이 같은지 다른지 알고 싶을 때 우리는 t-test를 하는 것입니다. 그런데, 여기서 우리가 집단 혹은 그룹이라고 표현하기는 했지만 통계학에서는 이를 표본(혹은 샘플)이라는 말로 사용합니다. 그런데 통계를 조금 공부해 보신 분들은 모두 알겠지만, 통계에는 표본(=sample)이라는 단어도 있고 모집단(=population)이라는 단어도 있습니다. 이 둘을 구분하지 못하면 우리는 t-test의 본질적인 의미 파악이 어려워집니다. 그러면 외국어라 생각하고 통계의 표본과 모집단의 차이에 대해 먼저 알아보고 갑시다.

2.1.4 표본과 모집단

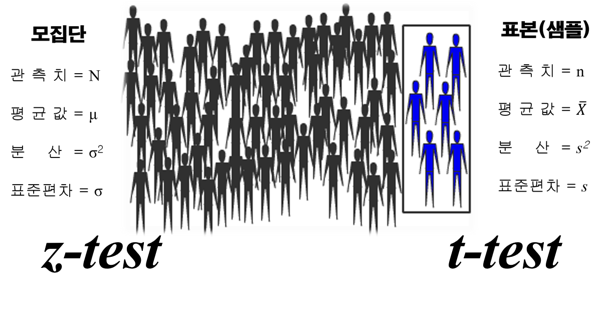

표본은 영어로 sample이라고 합니다. 그냥 우리말로 샘플이라고 쓰기도합니다. 저도 이 둘을 섞어서 사용하니 이해하시길 바랍니다. 모집단은 영어로 population이라고 합니다. 그러면 표본과 모집단의 차이는 무엇일까요? 다음의 그림을 한 번 봅시다.

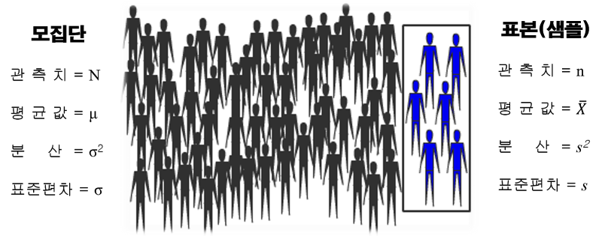

먼저 표본과 모집단의 차이를 이해하려면 Figure 2.2 를 보면 됩니다. 그림의 모든 사람을 모집단이라고 합니다. 즉, 모집단이란 우리가 연구하려는 대상 전체를 말합니다. 예를 들면 대한민국 성인남성의 키와 몸무게를 알고 싶다면, 이 연구의 모집단은 대한민국의 모든 성인남성이 됩니다. 정말 엄청나게 큰 숫자가 될 것입니다. 대한민국의 모든 성인남성을 모아서 키와 몸무게를 재는 일은 정말 엄청난 일입니다. 이러한 연구를 하겠다고 하면 개인의 수준에서는 불가능합니다. 그래서 통계에서는 모집단의 일부만을 대상으로 데이터를 모아서 연구를 합니다. 이때의 표본이 바로 이 모집단의 일부로 그림에서 우측의 검은 상자 안에 있는 파란색의 사람들을 의미합니다. 그러나 표본은 아무렇게나 모으는 것이 아닙니다. 샘플을 모으는 것을 샘플링이라고 하는데 이 샘플링은 매우 엄격한 기준에 의해 진행되어야 합니다. 왜냐하면 표본(샘플)이 항상 모집단을 대표할 수 있어야 하기 때문입니다.

또한 통계학에서는 모집단과 표본에 사용할 수 있는 기호를 분리해 두었습니다. 그림에서 보듯이 관측치라는 것은 흔히 데이터의 사이즈(크기)를 의미합니다. 설문조사를 했다면 설문에 응답한 응답자의 숫자가 바로 여기에 해당합니다. 문제는 같은 관측치 혹은 사이즈라고 해도 모집단의 경우에는 대문자 N을 사용하고, 샘플의 경우 소문자 n을 사용합니다. 여기서 주의할 점이 있습니다. 여러분들은 아마도 거의 평생에 모집단 데이터를 만날 일이 없을 것이라는 점입니다. 아주 일부의 운 좋은 그리고 능력 있는 사람들만이 이 모집단 데이터에 접근할 수 있지 않을까 생각됩니다. 저도 아직 모집단 데이터를 본적은 없습니다. 너무 거대한 데이터이므로 아마 제게 주어진다고 해도 쉽게 분석하기는 어렵지 않을까 생각합니다. 그러므로 우리가 논문을 쓰거나 보고서를 쓸 때, 통계적인 부분을 기술할 경우 데이터의 사이즈를 영문으로 표현할 때는 소문자 n을 사용하는 것이 맞습니다. 가끔 논문을 읽다보면 본인의 논문에 강력한 인상을 남기려는 것인지는 모르겠으나 샘플 사이즈를 n이 아닌 N으로 표기하는 경우를 간혹 봅니다. 잘못된 경우입니다.

다른 기호들을 살펴보겠습니다. 평균값을 보면 모집단은 \(\mu\) 라고 쓰여 있습니다. 그리스문자로 “뮤”라고 읽습니다. 의미는 평균값이고 모집단의 평균값입니다. 반면에, 샘플의 평균값은 \(\bar{x}\)라고 쓰여 있습니다. 이것은 “엑스 바”라고 읽습니다. 여기서 위의 줄이 하나 그어져 있는 것을 바(bar)라고 읽는 것이지요. 이것은 샘플 즉 표본의 평균입니다. 이러한 구분은 표준편차에서도 나타납니다. 모집단의 표준편차는 \(\sigma\) 이고 “시그마”라고 읽습니다. 반면에 샘플의 표준편차는 영어의 standard deviation의 소문자 s를 사용합니다. 물론 분산은 각 표준편차의 기호에 제곱을 하면 됩니다. 이제 여러분들은 통계라는 외국어의 기본언어를 익히신 것입니다. 어떤 책에 \(\mu\) 라고 쓰여 있으면, 아하 이것은 모집단의 평균값을 의미하는 구나하고 이해하시면 됩니다. 더불어 여러분들이 논문이나 보고서를 쓰실 때는 위의 모집단이 아닌 샘플에 해당하는 기호를 꼭 써야한다는 점을 기억하시기 바랍니다.

2.1.5 t-test의 목적을 더 알아보자

앞서 t-test의 목적은 두 집단이 같은지 혹은 다른지 알고 싶을 때 하는 통계적 분석방법이라고 했습니다. 이제 이를 좀 더 구체화해 봅시다. t-test의 목적은 두 집단이 동질한지 아니면 이질적인지를 통계적으로 분석하겠다는 것입니다. 그렇다면 어떻게 두 집단이 동질한지 혹은 이질적인지 알 수 있을까요? 너무 당연한 질문처럼 보이지만 매우 중요한 문제입니다. 만약 두 집단에 각각 10개의 데이터 값이 있을 때, 만약 이 값들을 1대1로 비교하겠다면 우리는 10×10=100개의 조합을 생각해야합니다. 게다가 이 100개의 비교를 어떻게 해야 할까요? 상당히 어려운 문제가 됩니다. 만약 각 집단에 1억 개의 데이터가 존재한다면 우리는 더 이상의 분석을 진행할 수 없을 것입니다. 그러면 이제 여기서부터 우리가 앞서 공부했던 통계의 대표적인 측정값들이 등장해야 합니다. 두 개의 집단을 비교하는데 우리는 어떤 통계적인 측정값을 이용할까요? 당연히 평균입니다. 왜 그럴까요? 앞서 이야기 한 것처럼, 평균값은 데이터의 중심을 대표하는 대푯값입니다. 그러므로 각 집단의 중심을 대표하는 대푯값인 평균값으로 비교하면 두 집단이 같은지 다른지 알 수 있습니다.

이렇게 대푯값으로서의 평균의 의미는 엄청납니다. 개별 데이터의 값들을 1대 1로 매칭해서 비교할 필요가 없습니다. 한 집단의 샘플 사이즈(n)가 1억 개라도 괜찮습니다. 지금의 컴퓨팅능력이면 평균값 정도는 쉽게 우리에게 알려줍니다. 이제 다시 우리는 앞의 t-test를 좀 더 구체적인 예제로 만들어 보겠습니다. 두 집단이 같은지 다른지를 평균값으로 비교하겠다는 것은 좀 막연한 느낌이 듭니다. 구체적인 예를 들어봅시다. 우리가 사는 동네에는 근처에 두 개의 대학이 있습니다. 하나는 A대학이고 다른 하나는 B대학입니다. 가까이에 있는 두 대학교이기에 평소에는 큰 차이를 느끼지 못했습니다. 그런데, 금년 봄에 이 두 대학의 학생들이 각자 자기 대학의 로고가 새겨진 점퍼를 입고 다니는 것을 자세히 보니, A대학과 B대학의 남학생들의 키가 좀 달라보였습니다. 궁금한 나머지 이와 관련한 t-test를 진행해 보기로 했습니다. 이를 우리 나름대로의 통계 프로젝트 No.1으로 명명하겠습니다. 이 프로젝트의 목적을 구체적으로 말하면 무엇일까요? 아마도 A대학과 B대학의 남학생의 평균키가 같은지 다른지 알아보겠다 정도가 될 것입니다.

이러한 프로젝트의 목적은 바로 t-test의 목적이 됩니다. 보다 구체적인 평균키가 궁금했던 나머지 우리는 두 대학에 연락하여 남학생의 평균키를 알려달라고 부탁했고, 다행스럽게도 두 대학의 남학생의 평균키를 다음과 같이 확인할 수 있었습니다.

이제 통계 프로젝트 No.1의 목적이자 t-test의 목적을 보다 통계적인 사고방식을 기반으로한 질문으로 바꿔보면 이렇게 될 것입니다.

- A대학 남학생 평균키(178.5cm)와 B대학 남학생 평균키(179.9cm)가 우연히 같은 확률은 얼마나 될까?

- A대학과 B대학의 남학생 평균키 차이인 1.4cm가 우연히 발생했을 확률은 얼마나 될까?

위의 두 질문은 같은 질문을 다른 방법으로 표현한 것 뿐입니다. 이제 우리는 기본적인 t-test의 목적을 이해했습니다. 첫 술에 배부를 수는 없습니다. 가야할 길이 아직 멀고도 멀어서 조금은 지칠 수도 있지만 원래 처음이 어려운 법입니다. 이제 첫 번째 산을 넘었으니 다음 산을 향해 나아가 봅시다.

2.2 몸풀기가 이렇게 어렵다니

2.2.1 그래서 어떻게 하겠다는 것일까?

앞에서 우리는 t-test의 목적이 무엇인지 그리고 우리의 예제를 t-test의 목적에 맞춰 통계적 의사결정 방법에 맞게 질문하는 법을 알아보았습니다. 우리가 하려는 t-test의 목적은 다음과 같습니다.

- A대학 남학생 평균키(178.5cm)와 B대학 남학생 평균키(179.9cm)가 우연히 같은 확률은 얼마나 될까?

- A대학과 B대학의 남학생 평균키 차이인 1.4cm가 우연히 발생했을 확률은 얼마나 될까?

여기서 두 집단이 다르다면, 즉 두 대학의 남학생의 평균키가 다르다는 의미가 될 것입니다. 평균키가 다르다는 것은 두 대학 남학생의 평균키의 차이가 크다는 의미가 될 것입니다. 위에서 보았듯이 두 대학 남학생의 평균키의 차이는 1.4cm 입니다. 어떤가요? 평균키의 차이가 큰 것인가요? 아니면 작은 것인가요? 여기부터가 진짜 통계입니다. 누군가는 이 차이가 크다고 할 것이고 누군가는 그냥 크지 않다고 할 수 있습니다. 만약 이 차이가 크다면 우리는 이 두 대학 남학생의 키 차이 1.4cm가 우연히 발생한 것이 아니라고 할 것입니다. 반면, 만약 이 차이가 작다면 우리는 이 두 대학 남학생의 키 차이 1.4cm가 우연히 발생한 것이라고 결론 내릴 것입니다. 그런데 도대체 얼마나 커야 큰 것이고 얼마나 작아야 작은 것일까요?

여기서 우리의 지혜가 필요합니다. 우리가 가진 숫자는 1.4cm의 차이라는 것뿐이고, 이 평균값의 차이만 가지고서는 이 값이 큰지 혹은 작은지 판단할 방법이 없습니다. 그러므로 우리는 판단에 도움이 될 만한 다른 참고할만한 숫자가 필요합니다. 그게 무엇일까요? 여태 우리가 배운 통계는 너무나 단순해서 아는 것이 없다고 생각할 수도 있으나 이미 여러분들은 답을 알고 있습니다.

무엇일까요? 바로 표준편차 (혹은 분산)입니다. 왜 그럴까요?

2.2.2 표준편차로 다시 돌아가자

앞에서 살펴보았던 예를 다시 봅시다. 우리가 가진 데이터가 {1, 2, 3, 4, 5}라고 합시다. 이 데이터의 평균은 아래와 같이 3입니다. 그리고 분산의 공식을 적용해서 분산을 구해보면 분산은 2.5입니다.

\[(1+2+3+4+5)\div5=3\]

\[\text{Variance}=s^2=\frac{\sum_{i=1}^n (x_i-\bar{x})^2}{n-1}\]

\[\frac{(1-3)^2+(2-3)^2+(3-3)^2+(4-3)^2+(5-3)^2}{4}=2.5\]

분산이란 우리가 가진 데이터가 평균을 중심으로 얼만큼 퍼져 있는가를 말해 주는 대푯값입니다. 즉, 평균값으로부터 데이터가 퍼져 있는 평균적인 거리(distance)입니다. 그럼 다시 생각해 봅시다. 우리의 데이터는 {1, 2, 3, 4, 5}였습니다. 평균은 3이고 분산은 2.5입니다. 여기에 다시 제곱근을 붙여 분산을 표준편차로 바꾸면 평균값과 단위가 일치하게 됩니다. 2.5에 제곱근을 씌우면 약 1.58정도 됩니다. 따라서 우리의 데이터는 3을 중심으로 플러스와 마이너스 양방향으로 1.58정도 퍼져 있는 것이고 그 범위는 대략 1.42부터 4.58까지 입니다.

중요한 것은 여기서 표준편차의 퍼져있는 정도 (=편차)가 의미 있는 (=원인이 있는) 편차인지 아니면 의미 없는 (=원인이 없는) 편차인지 알아야 합니다. 복잡한 설명을 다 차치하고 단순하게 생각해봅시다. A대학교의 남학생의 평균키는 178.5cm입니다, 이것은 평균일 뿐이고 A대학교 모든 남학생의 키가 178.5cm일 수는 없습니다. 그러면 이제 이 키라는 변수는 더 이상 변수가 아니고 상수가 될 것입니다. 또한, 현실에서 모든 A대학의 남학생의 키가 같은 것은 상상할 수 없습니다. 말도 안 되는 것이지요. 현실에서 아무리 키가 똑같아 보이는 두 사람일지라도 정밀한 장비로 키를 재본다면 아주 미세하게라도 분명히 차이가 날 것입니다. 그러므로 이러한 표준편차는 특별한 의미가 없는 혹은 특별한 원인이 없는 편차라고 보는 것이 당연합니다. 만약 이 편차에 뭔가 원인이 있거나 의미가 생겨버린다면 이는 사실 꽤나 고차원적인 통계로 넘어가게 됩니다. 지금 우리가 배우는 기초통계에서는 표준편차 (혹은 분산)이란 의미 없는 말 그대로 무작위의 (random) 편차입니다. 편차도 결국엔 일종의 차이 값이지요. 왜냐하면 표준편차란 평균값을 기준으로 데이터의 평균적인 차이일 뿐인 것이기 때문입니다.

그러므로 이제 우리는 두 대학의 평균키의 차이인 1.4cm가 큰 차이인지 작은 차이인지 결정할 수 있는 비교대상인 표준편차라는 새로운 숫자를 하나 더 가지게 되었습니다. 그렇다면 이제 다시 이 문제로 돌아와서 살펴봅시다. 두 대학의 평균키의 차이인 1.4cm는 다른 의미로 보자면 두 집단의 수많은 데이터들 사이의 평균적인 거리가 1.4cm라는 의미가 됩니다. 즉, 두 집단의 평균값의 차이도 일종의 편차인 것입니다. 여기서 이제 우리가 데이터를 통해 표준편차 s를 얻었다고 가정해 봅시다.

그러면 우리의 의사결정은 다음과 같은 방법으로 진행될 것입니다.

- 두 집단 A와 B의 데이터 사이의 평균적인 거리는 1.4cm이고

- 두 집단 A와 B의 데이터들의 표준편차는 Scm 입니다.

- 만약 이 1.4cm가 표준편차 Scm보다 현저히 작다면, 우리는 이 1.4cm의 차이에 큰 의미를 둘 수 없을 것이므로 이 1.4cm의 차이는 우연히 발생했다고 결론 내릴 것입니다.

- 그러나 만약 이 1.4cm가 표준편차 Scm보다 현저히 크다면, 우리는 이 1.4cm의 차이에 큰 의미를 둘 수 있을 것이므로 이 1.4cm의 차이는 우연히 발생하지 않았으며 무언가 이 차이에는 원인 혹은 이유가 있을 것이라고 결론 내릴 수 있을 것입니다.

2.2.3 통계는 분산의 마법이다

아직도 이 말이 어색하실 것입니다. 그러나 t-test부터 분산의 역할은 매우 중요합니다. 왜냐하면 평균값의 차이만 가지고서는 이 값이 충분히 큰지 혹은 충분히 작은지 판단할 수 없기 때문입니다. 그러므로 특별한 의미가 없는 무작위의 random한 차이인 표준편차를 가져와서 표준편차와 평균값의 차이를 비교하는 것이 t-test의 핵심입니다. 그러므로 이미 분산의 마법이 시작된 것이지요. 만약 우리에게 분산 (혹은 표준편차)가 없었다면 이러한 통계적인 분석은 불가능 했을 것입니다. 분산이나 표준편차가 통계에서 가지는 의미는 엄청납니다. 특히 기초통계에서는 분산과 표준편로 거의 모든 문제를 해결해 나갑니다. 그러므로 다시 한 번 마음속에 새겨두길 바랍니다. 통계는 분산의 마법입니다.

2.3 너무 빨리 먹으면 체합니다

우리는 앞서 t-test의 목적과 t-test를 위해서는 평균값의 차이뿐만 아니라 표준편차가 비교 대상으로서 필요하다는 것을 이해했습니다. 그러면, 이제 바로 t-test로 들어가야 하겠지만 아직 그 전에 넘어야할 산이 몇 개 있습니다. 바로 t-test로 직행하지 않는 이유는 제가 수년간 가르쳐보니 너무 빨리 먹으면 체하더라는 경험 때문입니다. t-test로 가기 전에 우리는 z-test라는 이유식을 먼저 먹고 갈 것입니다. 사실, 많은 통계책에서는 z-test와 t-test를 별개의 분석방법으로 보기도 하지만, 그 근본은 같은데서 시작한 것으로 z-test를 이해하게 되면 t-test를 이해하는데 도움이 많이 됩니다. 또한 이제부터 볼 z-test에 등장하는 내용들은 앞으로 통계에서 매우 자주 나오는 것이므로 잘 봐두시면 좋겠습니다. 일단 t-test와 z-test의 관계에 대해 알 수 있는 그림을 하나 보여드리겠습니다.

이미 앞에서 본 적이 있는 그림입니다. 차이가 있다면, 모집단 아래에 z-test라고 되어 있고, 표본 아래에 t-test라고 되어 있는 것이 다릅니다. 기본적으로 z-test와 t-test의 차이는 분석하는 데이터가 모집단일 경우에는 z-test를 하는 것이고, 분석하는 데이터가 표본일 경우에는 t-test를 한다는 것입니다. 그러니 이제 여러분들은 모집단에는 z-test 그리고 표본에는 t-test라고 외워두시면 됩니다. 그럼 이제 본격적으로 z-test에 대해 알아보겠습니다.

2.3.1 정규분포란?

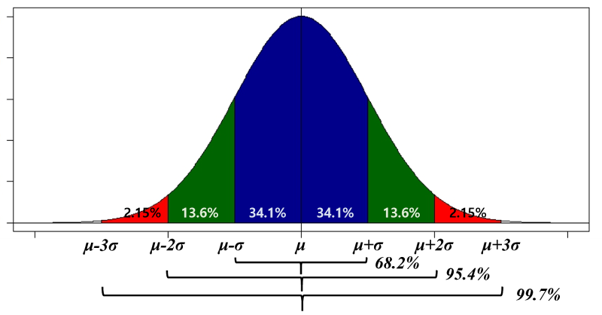

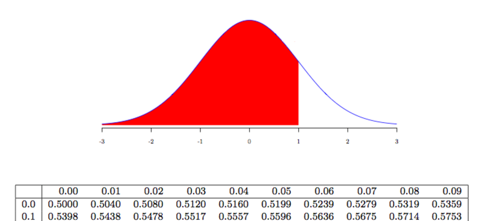

통계를 조금 공부해보신 분이라면 정규분포라는 말을 들어보셨을 것입니다. Figure 2.6 과 같이 생긴 것이 정규분포입니다. 흔히 정규분포를 종 모양 (bell shape)이라고 말합니다. 이 분포곡선은 가운데의 \(\mu\)인 평균값을 중심으로 좌우가 대칭인 곡선입니다. 즉, 정 가운데를 중심으로 접으면 양쪽이 똑같다는 뜻입니다. 또한 정규분포곡선의 양쪽 끝은 “0” (zero)을 향해 가지만 영원히 닿지는 않습니다. 아래의 그림에서 보면 두 개의 값만 있으면 정규분포를 규정할 수 있습니다. 바로 평균값 \(\mu\) 와 표준편차 \(\sigma\) 입니다. 앞에서 우리는 통계의 대푯값이 평균과 표준편차라고 했는데 이 두 개의 값으로 만들 수 있는 곡선이 바로 정규분포곡선입니다. 이 곡선은 통계에서 기본이 되는 중요한 곡선입니다.

문제는 보통은 여기까지 설명하고 끝이 난다는 점입니다. 물론 똑똑하신 분들이나 이공계분들에게는 너무 쉽고 당연한 것들이지만 문과돌이에게는 그래서 어쩌란 말인가 싶습니다. 여기서 중요한 것 두 가지를 이야기 하겠습니다.

- 평균과 표준편차가 다르다면 세상에는 무한대 개의 서로 다른 정규분포가 존재한다.

- 정규분포곡선 아래의 색깔을 칠한 면적이 확률이다

이 두 가지를 꼭 알아야 합니다. 특히 두 번째, 정규분포곡선 아래의 색깔을 칠한 면적은 확률을 의미한다는 이것이 매우 중요합니다.

그러므로 Figure 2.6 의 곡선 아래 면적의 합은 당연히 “1”이 됩니다. 왜냐하면 확률의 합은 1이기 때문입니다. 이러한 배경을 바탕으로 만약 우리가 가진 데이터가 정규분포를 따른다면, 우리는 평균과 표준편차 두 개의 값으로 많은 것을 알 수 있습니다. Figure 2.6 의 정 중앙은 평균값이며 이 평균을 중심으로 좌우로 1×표준편차만큼 좌우로 구간이 파란색을 칠해져 있습니다. 그 안의 34.1%라는 것이 바로 이 파란색 부분의 면적이자 확률입니다. 그러므로 평균값±1×표준편차의 구간 안에는 우리가 가진 데이터의 68.2%의 관찰값이 존재하게 됩니다. 전체 데이터의 절반 이상이 평균값을 중심으로 ±1×표준편차의 구간 안에 존재한다는 것입니다. 이를 이제 ±2×표준편차의 구간으로 확대해보면 파란색 바깥쪽의 초록색 구역이 됩니다. 즉 ±1×표준편차부터 ±2×표준편차의 구간 사이에 각각 13.6%의 데이터가 존재하고 이를 합하면 초록색의 면적은 27.2%가 되는 것을 알 수 있습니다. 그러므로 평균값을 중심으로 ±2×표준편차의 구간에는 총 95.4%의 데이터가 포함되게 되어 있습니다. 즉, 거의 모든 데이터가 이 안에 들어간다는 것입니다. 단 4.6%의 데이터만이 이 바깥에 존재합니다. 마지막으로 이 구간을 평균값을 중심으로 ±3×표준편차까지 확대하면 전체 데이터의 99.7%가 이 안에 존재합니다. 실로 놀라운 일입니다. 아닌가요?

2.3.2 p값과 정규분포곡선의 관계

여기서 한 가지 더 이야기할 것은 앞서 우리가 어떤 사건이 우연히 일어날 확률의 확률값이 바로 p값이라고 했습니다. 그런데, 이 p값을 어디서 어떻게 구하는 것인지에 대해서는 이야기 하지 않았습니다. 이 정규분포가 가지는 의미를 이야기 하자면, 정규분포의 아래 면적이 확률이라고 했습니다. 바로 이 면적이 우리가 구할 p값입니다. 물론 통계에는 정규분포 말고도 많은 분포곡선들이 존재합니다. 일단 여기서는 정규분포곡선만 생각합시다. 우리가 어떤 사건이 우연히 발생할 확률을 알고 싶다면 지금은 정규분포의 아래의 면적을 구해야 합니다. 그러려면 고등학교에서 배운 적분을 활용해야 합니다. 이미 예상하시다시피 정규분포곡선의 식을 적분을 하는 것은 가능한 일이지만 이는 문과돌이에게는 불가능에 가까운 일이며 미친 짓입니다. 그러니 이 문제를 해결할 필요가 있습니다.

2.3.3 표준 정규분포

보통 통계책들은 왜 표준 정규분포가 필요한지 설명하지 않고 바로 표준 정규분포의 특징을 이렇게 설명합니다. 표준 정규분포란 평균이 “0” (zero)이고 표준편차가 “1”인 정규분포를 표준 정규분포라고 한다. 맞는 설명입니다만 아직 우리가 왜 이 표준 정규분포가 필요한지 모르겠다는 데에 문제가 있습니다. 앞에서 우리는 이 세상에는 평균과 표준편차만 다른 무한대 개의 정규분포가 있다고 이야기 했습니다. 그리고 지금 우리는 이 정규분포의 아래쪽 면적을 구하고 싶습니다. 왜냐하면 이 면적이 곧 확률이며 이 확률이 바로 우리가 원하는 p값이기 때문입니다. 문제는 면적을 구하려면 적분을 해야하는데, 매번 적분을 해서 p값을 찾아내려면 우리는 거의 통계 자체보다 계산에 엄청난 노력과 시간을 보내야만 할 것입니다. 솔직히 저도 정규분포를 적분 할줄 모릅니다. 우리 문과돌이들의 애환이라고 할 수 있습니다.

사실 이 복잡한 적분을 할 수 있다고 해도 이는 분명히 시간과 노력의 낭비입니다. 그래서 친절한 우리의 통계학자들은 우리를 위해 표준 정규분포를 정의하고 표준 정규분포곡선의 아래쪽 면적을 친절하게 표로 만들어 주었습니다. 즉, 우리는 정규분포를 적분할 수고를 덜 수 있다는 것입니다. 이제 어떻게 이 표준 정규분포를 이용할지 알아 봅시다.

2.3.4 표준 정규분포 사용 예제

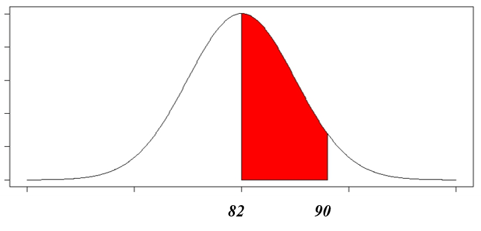

이제 다음의 예제를 사용하여 표준 정규분포를 사용해 봅시다. 금년 A 대학교는 신입생 1000명을 대상으로 영어 실력 고사를 시행하였습니다. 시험 결과 영어점수의 분포가 정규분포에 근사하였습니다. 여기서 근사란 정규분포를 비슷하게 따랐다는 것을 의미합니다. 그러므로 우리는 영어 점수에 정규분포를 적용할 수 있습니다. 영어시험 결과 평균점수는 82점이었고 표준편차는 5점이었습니다. 이 때, 82점부터 90점까지의 점수를 받은 학생 수는 몇명일까요?

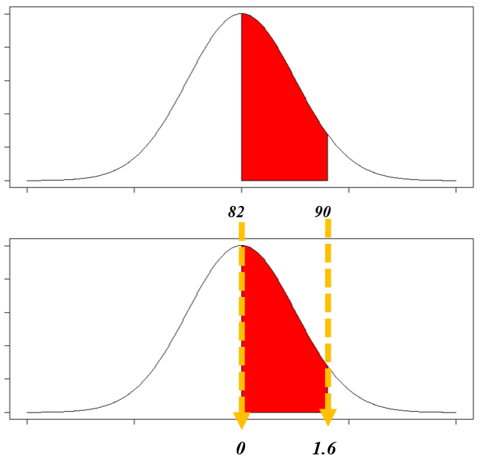

만약 이 문제를 적분해서 풀으려 한다면 평균이 82이고 표준편차가 5인 정규분포곡선에서 Figure 2.7 처럼 82점부터 90점까지의 붉은 부분의 면적에 적분을 적용해 계산해야 합니다. 이 면적이 곧 확률이므로 “계산된 확률×1000명”을 구해보면 82점부터 90점까지의 점수를 받은 학생 수를 구할 수 있습니다. 그런데 이걸 적분할 수 있을까요? 불가능합니다. 아니 정확히는 무의미합니다.

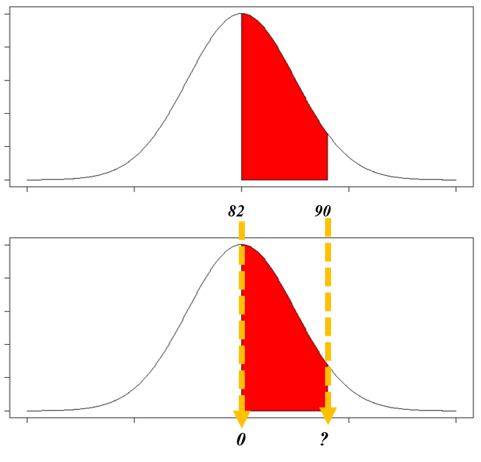

그래서 우리는 Figure 2.7 의 붉은 부분을 적분하는 대신에 우리가 가진 정규분포곡선을 표준 정규분포곡선으로 변환해야 합니다. 그 방법이 바로 표준화입니다. 표준화 공식을 알아보기 전에 위의 정규분포가 어떻게 표준 정규분포가 될 수 있는지 그림으로 먼저 살펴보겠습니다.

Figure 2.8 를 살펴보면 위쪽의 정규분포는 우리가 가진 1000명의 학생의 시험점수를 그린 것입니다. 중앙의 평균값이 82점이고 우리가 알고 싶어 하는 90점까지의 구간이 붉은 색으로 칠해져 있습니다. 이를 표준 정규분포로 바꾸어야 하는데 기본적인 개념은 이렇습니다. 화살 점선으로 표현되어 있듯이 정규분포의 중앙의 82점은 자연스럽게 표준 정규분포의 “0”으로 전환됩니다. 왜냐하면 지금 이 부분은 평균값이기 때문에 굳이 계산을 하지 않아도 알 수 있습니다. 문제는 우리가 가진 정규분포의 90점이 표준 정규분포에서 얼마인지 알 수는 없습니다. 이 값을 알려면 표준화 공식을 적용해야 합니다. 표준화란 말 그대로 데이터를 표준화된 숫자로 변경하는 것입니다. 표준화의 장점은 단위(unit)가 없어진다는 점입니다. 일단 표준화 공식을 확인해 보겠습니다.

\[\text{z-score}=\frac{x-\mu}{\sigma}\]

z-score란 표준화점수로 z값이라고도 합니다. 분자의 \(x\)는 우리가 원래 가지고 있던 숫자입니다. 예제에서 평균점수인 82점이나 우리가 알고 싶어 하는 90점이 이 \(x\)에 속합니다. 그 다음에 등장하는 \(\mu\)는 당연히 평균값이고 분모의 \(\sigma\)는 표준편차입니다. 쉽게 말해 표준화란 주어진 값에서 평균값을 뺀고난 후 표준편차로 나누어준 수입니다. 이렇게되면 앞서 이야기 했듯이 원래 \(x\)가 가지고 있던 단위(unit)가 사라집니다. 이 z값을 굳이 해석해 보자면, 1 표준편차당 관찰값(\(x\))가 평균으로부터 얼마나 떨어져 있는지를 의미합니다.

그럼 이제 82점과 90점을 표준화 공식에 따라 변경해보겠습니다. 이 방법을 영어로는 z-transformation이라고도 합니다.

\[z_{82}=\frac{82-82}{5}=0\] \[z_{90}=\frac{90-82}{5}=1.6\]

\(z_{82}\)는 원래의 82점을 z값으로 변환한 값이라는 의미입니다. 82점에서 평균점수인 82점을 빼고난 후 표준편차 5로 나누면 0 (zero)이 됩니다. 즉, 우리가 원래 가지고 있던 정규분포의 82점을 표준 정규분포상의 0 (zero)으로 변환한 것입니다. 이는 위의 Figure 2.8 에서 보아도 알 수 있는 사실입니다. 다음으로 우리가 가진 정규분포상의 90점을 표준 정규분포로 전환하려면 90에서 평균인 82를 빼고 이를 다시 5로 나누면 됩니다. 결과는 1.6이 됩니다. 즉, 우리가 가진 정규분포에서의 90점은 표준 정규분포상에서 1.6이 됩니다. 흔히 이것을 z값이 1.6이라고 표현합니다. 그러므로 우리가 구하고자 하는 면적은 표준 정규분포상에서 0부터 1.6까지의 면적이 됩니다. 이 면적을 구하려면 원래는 적분을 해야하지만 친절하게도 통계학자들이 이 면적 즉 확률에 관한 표를 만들어 두었습니다. 이것을 z-table이라고 하는데 모든 통계 교과서의 뒤쪽에 항상 포함되어 있으며 인터넷에서 표준 정규분포표라고 검색하면 찾을 수 있습니다. 이제 우리는 이 z-table을 이용하여 확률을 구해보겠습니다.

2.3.5 표준 정규분포표의 사용법

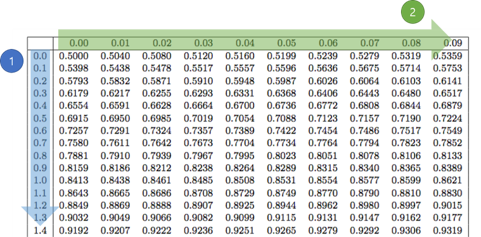

인터넷에서 표준 정규분포표를 검색하여 사용해보겠습니다. 아래의 Figure 2.9 는 표준 정규분포표의 상단입니다. 책마다 다소 다르게 사용할 수도 있으니 이부분을 잘 보는 것이 중요합니다. 상단에 표준 정규분포 곡선이 있고 붉은색으로 왼쪽 끝부터 1까지 면적이 표시되어 있습니다. 이것이 의미하는 바는 이 표준 정규분포표는 좌측 끝부터 해당 z값까지의 확률값을 표현하고 있다는 의미입니다.

그러면 이제 표준 정규분포표의 구성을 보겠습니다. Figure 2.10 에 표준 정규분포표를 잘라서 보여드리겠습니다. 표준정규분포표에서 우리가 원하는 값을 찾는 방법은 다소 독특합니다. 표준 정규분포표의 가장 왼쪽의 첫번째 열은 소수 첫번째 자리까지만 표현되어 있습니다. 그리고 표의 가장 상단 첫번째 행에는 소수 둘째 자리가 표현되어 있습니다. 따라서 우리가 찾는 z값이 0.40이라면 좌측 첫번째 열에서 0.4를 찾고 그 행에서 0.00에 속하는 값을 읽으면 0.6554가 됩니다. 이는 Figure 2.9 가 설명하듯, 표준 정규분포의 왼쪽 끝부터 z값인 0.40까지의 면적이자 확률이 0.6554라는 것이고 이를 환산하면 65.54%가 됩니다. 만약 우리가 찾는 z값이 0.45라면 좌측 첫번째 열에서 0.4를 찾고 그 행에서 0.05에 해당하는 값인 0.6736이 바로 확률값이 됩니다. 이런 방식을 적용하면 적분을 하지 않고 우리가 원하는 확률값을 찾을 수 있습니다.

다시 우리의 예제로 돌아와 봅시다. 우리가 원하는 것은 Figure 2.11 에 있습니다.

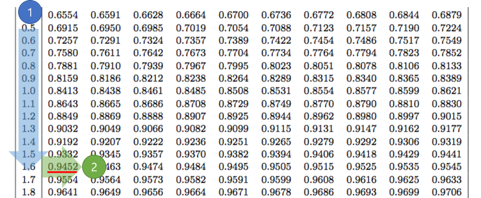

우리는 원래 가지고 있던 90점을 표준화하여 z값 1.6을 구했습니다. 그러므로 표준 정규분포표 즉 z-table에서 찾아야 하는 z값은 1.6입니다. 그러면 이제 다시 표준 정규분포표로 돌아가 z값 1.6에 해당하는 확률값을 찾아 봅시다.

앞에서 해보았듯이 우리가 찾을 값은 1.6이므로 첫번째 열에서 1.6을 찾고 0.00에 해당하는 값을 찾으면 됩니다. 그림에서 볼 수 있듯이 0.9452입니다. 그런데 Figure 2.9 와 Figure 2.11 를 비교해 보면, 우리가 원하는 것은 평균값 0을 중심으로 좌측의 면적은 제외한 것을 찾고 싶습니다. 그렇다면 어떻게 해야할까요? 앞서 우리는 정규분포곡선의 특징을 이야기할 때, 평균값을 중심으로 좌우대칭이라는 이야기를 했습니다. 그러므로 평균값 0을 중심으로 좌측의 확률은 0.5가 됩니다. 그러므로 우리가 원하는 확률은 0.9452 - 0.5 = 0.4452가 됩니다. 즉, 44.52%인 것입니다. 그러므로 이 확률에 1000명을 곱하면 44.52% × 1000 ≈ 445명 정도가 됩니다. 그러므로 1000명의 신입생을 대상으로 시험을 본 결과 평균이 82점 표준편차 5점을 따르는 정규분포인 경우 82점부터 90점까지 받은 학생은 대략 445명이라는 것입니다. 지금까지 우리가 한 이것이 바로 z-test입니다.

z-test를 정리해 보자면 우리가 가진 데이터가 정규분포곡선을 따를 때, 우리는 우리가 원하는 어떤 값을 이용해 확률을 구할 수 있는데, 굳이 적분할 필요는 없고 이를 표준 정규분포로 전환한 후에 표준 정규분포표를 사용하면 된다는 것입니다. 여기서 표준 정규분포를 이용하기 위해서 우리는 기존의 데이터의 값을 z값으로 변환해야 하는데, 이를 z-transformation이라고 하고 표준화라고 하기도 합니다.

2.3.6 배운 것들을 연결해보자

우리가 배운 것들을 처음부터 지금까지 연결해보겠습니다.

- 통계적 사고방식이란 어떤 사건이 우연히 발생할 확률이 얼마일까 질문하는 것이다.

- 여기서 말하는 어떤 사건이 우연히 발생할 확률이 바로 p값이다.

- 만약 p값이 0.05보다 작다면 대립가설을 선택하고 (귀무가설을 기각하고) 유의하다고 하며, 이때 우리는 이 사건이 우연히 발생하지 않았으며 무엇인가 원인 (혹은 이유)가 있다고 판단한다.

- 반면에, p값이 0.05보다 크다면 대립가설을 기각하고 (귀무가설을 선택하고) 이 사건은 우연히 발생했다고 판단한다.

- 정규분포곡선과 같은 확률분포곡선의 아래쪽 면적이 우리가 찾는 p값 즉 확률값이다.

- 그러므로 우리가 찾고자 하는 p값은 확률분포곡선 (여기서는 정규분포곡선)의 아래 면적을 적분으로 구해야한다.

- 정규분포곡선을 적분하는 것은 미친짓이다.

- 그러므로, 우리가 가진 정규분포를 표준 정규분포로 전환하기 위해 z값을 구한다.

- 계산된 z값을 표준 정규분포표를 이용해 확률값을 찾아 사용한다.

이해가 되시나요? 이 과정이 바로 z-test입니다. 사실 이러한 과정은 우리가 배울 t-test도 동일합니다. 약간의 변형이 있을 뿐입니다. 그러면 다시 t-test의 예제로 돌아가서 t-test의 목적을 살펴봅시다.

- A대학 남학생 평균키(178.5cm)와 B대학 남학생 평균키(179.9cm)가 우연히 같은 확률은 얼마나 될까?

- A대학과 B대학의 남학생 평균키 차이인 1.4cm가 우연히 발생했을 확률은 얼마나 될까?

위에서 우리가 찾는 확률이 바로 p값이면서 우리는 이 p값을 확률분포곡선을 이용해 찾아낼 것입니다. 다만 우리는 여기서는 z-test가 아닌 t-test를 해야하므로 우리가 사용할 확률분포곡선은 정규분포곡선이 아닌 t-분포곡선을 사용할 것입니다. 여러 종류의 확률분포곡선이 존재하지만 이것들에 대해 지금 더 알아가는 것은 그다지 도움이 되지 않고 통계공부의 어려움만 증가할 뿐이라서 차근차근 알아가 보겠습니다. 이제 여러분은 통계적인 분석의 문을 열고 방금 그것을 시작했습니다. 축하합니다! 스스로를 칭찬해 줍시다!!

2.4 단순하지만 헷갈릴 수도

2.4.1 t-test를 바로 시작하지 못하는 두번째 이유

우리는 t-test를 하기에 앞서 z-test를 배웠습니다. 이제 바로 t-test를 해도 될 것 같은데 여기서 한 가지 짚고 넘어가야 하는 문제가 있습니다. 바로 양측검정과 단측검정입니다. 사실 매우 어려운 개념은 아닙니다만 가끔 결정적인 순간에 헷갈리는 것입니다. 통계적 가설에 대한 이야기인데 다시 통계적 가설로 돌아가 봅시다. 우리가 지금 수행할 t-test의 예제를 다시 확인해 보면 Figure 2.4 와 같습니다.

우리는 A대학과 B대학의 남학생들의 평균키가 같은지 다른지 알고 싶습니다. 앞서 통계학자들은 가설을 먼저 세우고 이를 검증해나가는 방식의 과학적 연구방법을 만들었다고 했습니다. 이를 위해 우리는 통계적 가설로서 귀무가설과 대립가설을 만들어야 합니다. 물론 말로 만들 수도 있습니다.

- 귀무가설: A대학과 B대학 남학생의 평균키는 같다

- 대립가설: A대학과 B대학 남학생의 평균키는 다르다

위와 같이 만들 수 있겠죠. 그런데 같은 내용을 약간 다른 말로 만들어 볼 수도 있습니다.

- 귀무가설: A대학과 B대학 남학생의 평균키의 차이는 0이다

- 대립가설: A대학과 B대학 남학생의 평균키의 차이는 0이 아니다

이렇게 크게 두 가지로 귀무가설과 대립가설을 만들어 볼 수 있습니다. 그러나 통계학자들은 이러한 가설을 말로 쓰는 것을 별로 좋아하지 않았습니다. 그래서 이러한 통계적 가설을 기호로 표기하였습니다. 첫번째의 경우는 아래와 같이 표현될 수 있습니다.

- \(H_0: \bar{x}_a = \bar{x}_b\)

- \(H_a: \bar{x}_a \ne \bar{x}_b\)

그런데 여기서 우리는 대립가설에 주목할 필요가 있습니다. 첫번째의 \(\bar{x}_a\)는 A대학 남학생의 평균키를 \(\bar{x}_b\)는 B대학 남학생의 평균키를 의미합니다. 여기서 \(\mu\)를 사용하지 않는 이유는 우리가 사용한 데이터는 샘플 데이터이기 때문입니다. 대립가설은 두 대학 남학생의 평균키가 다르다라고만 되어 있습니다. 이 “다르다”라는 말은 다분히 논리적인 의미로서 무엇이 어떻게 다르다는 것인지에 대해서는 아무런 세부사항을 이야기 하고 있지 않습니다. 그렇다면, 저 두 개의 평균값이 다를 수 있는 경우는 몇 가지가 있을까요? 아마도 두 가지 일 것입니다.

\[\bar{x}_a \ne \bar{x}_b \Rightarrow \bar{x}_a > \bar{x}_b \; \text{or} \; \bar{x}_a < \bar{x}_b\]

이렇게 말입니다.

즉, “다르다”는 A대학 남학생 평균키가 B대학 남학생 평균키 보다 크거나 작은 두 가지의 경우를 모두 포함합니다. 이렇게 되면 앞에서 쓴 통계적 가설을 다른 표현이지만 같은 의미로 이렇게도 사용할 수도 있습니다.

- \(H_0: \bar{x}_a = \bar{x}_b\)

- \(H_a: \bar{x}_a > \bar{x}_b \; \text{or} \; \bar{x}_a < \bar{x}_b\)

이렇게 되면 귀무가설은 동일하고 대립가설만 바꾼것이지만 앞의 것과 의미는 동일합니다. 이 두가지는 말로 표현하자면 A대학과 B대학 남학생의 평균키는 같다 혹은 다르다를 귀무가설과 대립가설로 쓴 것입니다. 만약 A대학과 B대학 남학생의 평균키의 차이는 0이다 혹은 아니다를 통계적 가설로 쓴다면 이렇게도 바꿔 쓸 수 있습니다.

- \(H_0: D_{a-b} = 0\)

- \(H_a: D_{a-b} \ne 0\)

당연한 이야기이지만 이는 또 이렇게도 바꿔 쓸 수 있습니다.

- \(H_0: D_{a-b} = 0\)

- \(H_a: D_{a-b} > 0 \; \text{or} \; D_{a-b} < 0\)

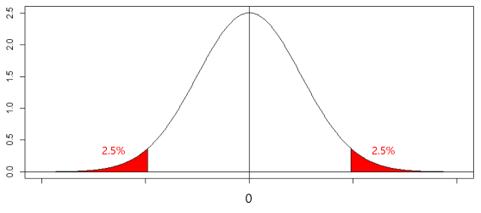

그러면 총 4개의 통계적 가설이 사실 내용을 같은 내용이라는 것이 됩니다. 이처럼 대립가설에서 단순히 같지 않다 혹은 다르다 라고 표현되는 경우를 우리는 양측검정이라고 합니다. 왜냐하면 단순히 다르다 라고만 하면 이는 클 수도 있고 작을 수도 있다는 의미가 되기 때문입니다. 즉 우리는 양측검정의 경우 클 수도 있는 경우와 작을 수도 있는 경우 두 가지를 모두 동시에 생각해서 p값을 구해야 한다는 의미가 됩니다.

반면에 단측검정이란 대립가설에서 한 방향으로 명확하게 그 방향성이 정해진 경우를 의미합니다. 예를 들어보면 이렇습니다.

- \(H_0: \bar{x}_a = \bar{x}_b\)

- \(H_a: \bar{x}_a > \bar{x}_b\)

이 경우에는 A대학 남학생의 평균키가 B대학 남학생의 평균키보다 크다는 방향성을 정확하게 제시하고 있습니다. 이러한 경우를 단측검정이라고 합니다. 또한 이를 앞에서 살펴본 것처럼 다르게 표현할 수도 있습니다.

- \(H_0: D_{a-b} = 0\)

- \(H_a: D_{a-b} > 0\)

이렇게 말입니다. 그렇다면 당연히 B대학의 남학생 평균키가 A대학의 남학생 평균키 보다 크다는 통계적 가설도 만들 수 있을 것입니다.

- \(H_0: \bar{x}_a = \bar{x}_b\)

- \(H_a: \bar{x}_a < \bar{x}_b\)

이를 다른 방식으로 표현하면 이렇게도 할 수 있습니다.

- \(H_0: D_{a-b} = 0\)

- \(H_a: D_{a-b} < 0\)

이런 경우를 모두 단측검정이라고 합니다. 즉 크거나 작은 경우 중에 한 가지만을 대상으로 p값을 구하는 경우입니다. 그렇다면 양측검정과 단측검정을 그림과 함께 알아보겠습니다.

2.4.2 확률분포곡선으로 보는 양측검정과 단측검정

이제 우리는 아래의 통계적 가설이 모두 같은 의미라는 것을 알고 있습니다. 한 번 보시길 바랍니다.

귀무가설: A대학과 B대학 남학생의 평균키는 같다

대립가설: A대학과 B대학 남학생의 평균키는 다르다

\(H_0: \bar{x}_a = \bar{x}_b\)

\(H_a: \bar{x}_a \ne \bar{x}_b\)

\(H_0: \bar{x}_a = \bar{x}_b\)

\(H_a: \bar{x}_a > \bar{x}_b \; \text{or} \; \bar{x}_a < \bar{x}_b\)

귀무가설: A대학과 B대학 남학생의 평균키의 차이는 0이다

대립가설: A대학과 B대학 남학생의 평균키의 차이는 0이 아니다

\(H_0: D_{a-b} = 0\)

\(H_a: D_{a-b} \ne 0\)

\(H_0: D_{a-b} = 0\)

\(H_a: D_{a-b} > 0 \; \text{or} \; D_{a-b} < 0\)

이러한 양측검정의 통계적 가설을 확률분포곡선과 연결해서 보면 이렇습니다.

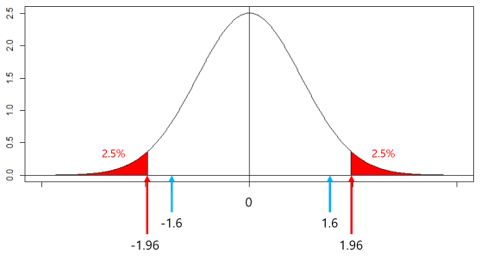

우리는 두 대학중 어느 한 대학이 클 수도 혹은 작을 수도 있는 두 가지의 가능성을 모두 생각해 둬야 합니다. Figure 2.13 에서는 편의상 표준 정규분포를 이용하여 보여드립니다. 실제 t-test를 할 때는 t분포를 이용해야 합니다. 그러나 여기서는 양측검정의 이해를 돕기위한 것이므로 표준 정규분포로 이해해 봅시다. 우리가 관심 있는 p값은 여전히 5% (0.05)입니다. 그러므로 양쪽에 이 5%을 분배하여 2.5%씩 붉은색으로 칠 했습니다. 위의 분포곡선에서 아래의 \(x\)축은 우리가 계산한 어떤 z-값을 의미 합니다. 앞에서 90점이라는 영어점수를 1.6으로 표준화했을 때의 1.6과 같은 값을 의미합니다. 그러므로 만약 붉은 면적 아랫부분의 z값이 1.6이라면 우리는 5%의 확률을 얻은 것입니다. 그러나 실제로 표준정규분포에서 양측검정으로 5%가 되려면 그때의 z값은 1.96이 되어야 합니다. 이를 Figure 2.14 로 확인해보면 보다 쉽게 이해할 수 있습니다. 그림에서 보듯, 양측검정에서 p값 5%를 맞추기 위해서는 -1.96과 1.96이 되어야 합니다. 즉, z값이 1.96이거나 혹은 -1.96이면 정확히 5%가 됩니다. 이러한 값을 우리는 c.v. (critical value)라고 합니다. 즉, 우리가 z-test를 할 때 항상 z값이 1.96보다 크거나 -1.96보다 작다면 우리는 양측검정에서 5%보다 작은 p값을 가지게 되어 대립가설을 채택하게 됩니다. 그림에서처럼 만약 우리의 z값이 1.6이거나 혹은 -1.6이라면 어떻게 될까요? 그림을 잘 보면 z값이 1.6이거나 -1.6일 경우 각 값에서 선을 위로 그어 표준 정규분포에 맞닿도록 하면 그림의 붉은 면적보다 더 넓은 면적이 양쪽으로 나나타게 됩니다.

이렇게 되면 면적이 5%보다 넓어지게 되므로 당연히 p값은 5%보다 커지게 되어 귀무가설을 채택하게 됩니다. 즉 이 사건은 우연히 발생한 것이 됩니다. 즉 우리는 양측검정에서 표준 정규분포를 이용할 경우 우리가 구하는 z값이 1.96보다 크거나 -1.96보다 작을 것을 기대해야 5%보다 작은 p값을 얻을 수 있는 것입니다.

이제 단측검정을 살펴봅시다. 앞의 양측검정은 둘 중 어느 대학의 남학생의 평균키가 크더라도 관계가 없습니다. 우리는 단지 다를 것을 기대했을 뿐입니다. 그러나 단측에서는 방향성을 명확하게 가설에 포함시키게 됩니다. 다음의 네 가지 경우는 같은 의미입니다. 어떤 책에서는 이를 우측검정이라고 부르기도 합니다.

귀무가설: A대학과 B대학 남학생의 평균키는 같다

대립가설: A대학 남학생의 평균키는 B대학 남학생의 평균키보다 크다

귀무가설: A대학과 B대학 남학생의 평균키의 차이는 0이다

대립가설: A대학과 B대학 남학생의 평균키의 차이는 0 보다 크다

\(H_0: \bar{x}_a = \bar{x}_b\)

\(H_a: \bar{x}_a > \bar{x}_b\)

\(H_0: D_{a-b} = 0\)

\(H_a: D_{a-b} > 0\)

그리고 당연히 반대 방향의 다른 종류의 단측검정이 하나 더 있습니다. 아래의 네가지 통계적 가설은 모두 같은 의미입니다. 어떤 책에서는 아래의 경우를 좌측검정이라고도 부릅니다.

귀무가설: A대학과 B대학 남학생의 평균키는 같다

대립가설: A대학 남학생의 평균키는 B대학 남학생의 평균키보다 작다

귀무가설: A대학과 B대학 남학생의 평균키의 차이는 0이다

대립가설: A대학과 B대학 남학생의 평균키의 차이는 0 보다 작다

\(H_0: \bar{x}_a = \bar{x}_b\)

\(H_a: \bar{x}_a < \bar{x}_b\)

\(H_0: D_{a-b} = 0\)

\(H_a: D_{a-b} < 0\)

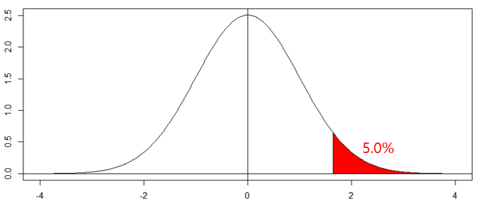

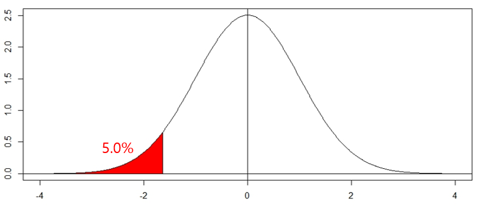

그럼 이제 단측검정을 그림으로 알아봅시다. <그림 1-16>은 단측검정 중에서도 우측검정을 보여주고 있습니다. 예상하듯이 우리가 원하는 p값 5%를 우측으로 몰았습니다. 이때의 c.v. 는 표준 정규분포의 경우 1.64정도가 됩니다. 즉, 우리가 구한 z값이 1.64보다 크다면 이는 p값이 5% 보다 작아 유의하게 되는 것입니다. <그림 1-17>은 단측검정의 좌측검정을 보여줍니다. 그림을 사실 좌우로 대칭시킨 정도의 차이만 있을 뿐이며 이 경우의 c.v. 역시 마이너스만 붙인 -1.64가 됩니다. 즉, 우리가 구한 z값이 -1.64보다 작으면 p값은 5%보다 작아지는 것입니다.

그런데, 여기까지 보고나니 좀 헷갈리는 것이 있습니다. 일단, 양측검정과 단측검정의 차이는 대립가설의 차이라는 것은 확실히 알겠습니다. 왜냐하면 귀무가설은 항상 똑같기 때문입니다. 그렇다면 이 대립가설의 차이는 언제 누가 어떻게 정해야 할까요? 사실 여러분들이 단순히 시험을 보기 위해서라면 아마도 시험문제에서 단측인지 양측인지 이야기해줄 것입니다. 그러나 가끔 문제 안에 이 내용을 살짝 넣어 버리는 경우가 있습니다. 더 정확하게는 여러분들이 연구할 때는 어떻게 해야 할까요? 여기서 여러분들이 헷갈리면 안되는 것이 하나 있습니다. 통계가 만능이 아니라는 점입니다. 통계는 어디까지나 여러분들이 수행하고 있는 과학적 연구에 있어서 검증방법의 하나로 사용되고 있다는 점입니다.

기본적으로 대립가설은 이미 연구자가 기존의 이론과 연구들을 모두 섭렵하고 난 후에 논리적인 기반을 탄탄하게 갖추고서 대립가설을 결정하는 것입니다. 그러므로 여러분들이 하고 있는 연구의 대립가설이 방향성이 있는지 없는지를 살펴보아야 합니다. 방향성이 없다면 즉 클 수도 있고 작을 수도 있다면 양측검정이 적용되어야 하고, 방향성이 분명하다면 즉 어떤 이유나 논리로 인해 크거나 작다는 한 쪽을 명확히 할 수 있다면 단측검정이 되는 것입니다. 그러므로 양측이냐 단측이냐는 통계 자체가 해결해 주는 것이 아니라 여러분들이 연구할 때 연구자가 얼마나 충분히 이론/기존연구/논리를 고려했느냐에 달려있는 것입니다. 추가적으로 통계적 가설의 대립가설을 말로 풀어쓴 것이 논문에 사용되는 연구가설이라는 점을 참고 하시기 바랍니다.

두번째로 헷갈리는 것은 단측검정에서 우측검정과 좌측검정 중에서 무엇을 써야 하느냐 입니다. 사실 이 문제는 약간의 트릭이 있습니다. 우리가 사용하는 확률분포가 좌우대칭이라면 사실 고민할 것이 없습니다. 왜냐하면 접으면 똑같기 때문입니다. 앞에서 우리는 A대학 남학생의 평균키를 178.5cm, B대학 남학생의 평균키를 179.9cm로 했습니다. 두 평균값의 차이를 구할 때, A에서 B를 빼면 -1.4cm가 되고, B에서 A를 빼면 1.4cm가 됩니다. 그러므로 차이가 양수라면 우리는 자연스럽게 우측검정을 하면 되고, 차이가 음수라면 우리는 자연스럽게 좌측검정을 하면 됩니다. 두 가지 방법의 결론은 어차피 같기 때문에 우리는 크게 걱정할 것이 없습니다. 마치 데칼코마니처럼 둘은 접으면 동일한 분포곡선이기 때문입니다. 물론 만약에 우리가 사용할 확률분포가 좌우대칭이 아니라면 이야기는 좀 달라질 수 있지만 일단 여기까지 이해하는 것이 중요합니다. 이제야 본격적인 t-test를 공부할 준비가 끝났습니다. 사실 여기까지만 잘 이해하셨다면 t-test는 우리가 이미 아는 내용의 응용에 불과하기 때문에 의외로 쉽게 이해될 것입니다. 달려봅시다!!

2.5 이제야 t-test를 하다니

2.5.1 t-test로 돌아가자

이제서야 우리는 t-test를 할 수 있게 되었습니다.

혹시 잊어버렸을지 모르니 다시 앞에서 한 것들을 복습해 봅시다. 기본적으로 t-test의 목적은 두 그룹이 같은지 다른지 알아보기 위해 실시하는 통계적 검정방법입니다. 여기서 두 그룹이란 샘플을 의미합니다. 만약 이 두 그룹이 모집단이라면 우리는 z-test를 할 것입니다. 그리고 두 샘플이 같은지 다른지 알고 싶어서 대표값인 평균값이 같은지 다른지 확인할 것입니다. 문제는 두 샘플의 평균값을 알고 이 차이를 알아도 이 차이가 얼마나 커야 통계적으로 큰 것인지 혹은 얼마나 작아야 통계적으로 작은 것인지 알 길이 없습니다. 그래서 우리는 이 차이가 큰지 혹은 작은지 판단하기 위해 참고가 될만한 다른 대표값을 가져와서 비교하기로 했습니다. 그것은 바로 표준편차입니다. 표준편차는 평균을 중심으로 데이터가 평균적으로 퍼져있는 정도입니다. 이 편차는 의미 없는 편차이며 단지 무작위적(random)으로 퍼져 있는 것입니다. 그러므로 우리가 계산한 평균값의 차이가 표준편차보다 충분히 크다면 우리는 이 평균값의 차이가 우연이 아니라고 판단할 것이지만, 반대로 평균값의 차이가 표준편차보다 작거나 비슷하다면 이 평균값의 차이는 우연이라고 판단할 것입니다. 우리가 풀려고 했던 예제는 다음의 그림입니다(Figure 2.4).우리는 두 대학의 남학생의 평균키가 달라야 할 만한 특별한 이유를 알지 못하고 그 방향성 또한 모르기 때문에 양측검정으로 이 분석을 진행할 것입니다.

귀무가설: A대학과 B대학 남학생의 평균키는 같다

대립가설: A대학과 B대학 남학생의 평균키는 다르다

\(H_0: \bar{x}_a = \bar{x}_b\)

\(H_a: \bar{x}_a \ne \bar{x}_b\)

\(H_0: \bar{x}_a = \bar{x}_b\)

\(H_a: \bar{x}_a > \bar{x}_b \; \text{or} \; \bar{x}_a < \bar{x}_b\)

귀무가설: A대학과 B대학 남학생의 평균키의 차이는 0이다

대립가설: A대학과 B대학 남학생의 평균키의 차이는 0이 아니다

\(H_0: D_{a-b} = 0\)

\(H_a: D_{a-b} \ne 0\)

\(H_0: D_{a-b} = 0\)

\(H_a: D_{a-b} > 0 \; \text{or} \; D_{a-b} < 0\)

이것이 바로 우리의 통계적 가설입니다. 그럼 이제 무엇이 필요할까요? 기본적으로는 앞에서 했던 z-test의 과정과 비슷합니다. z-test를 할 때 우리는 먼저 z값을 구했고 이를 표준정규분포를 이용하여 진행했습니다. 그러므로 우리가 t-test를 진행하기 위해서는 t-test에 맞는 값과 분포가 필요할 것입니다. 이 것이 바로 t값과 t분포입니다. 그냥 이름 앞에 t만 넣으면 되는 방식입니다. 그렇다면 t값 (t-value)의 공식을 z값 (z-value)의 공식과 함께 비교해 보도록 합니다.

\[\text{z-value}=\frac{x-\mu}{\sigma}\] \[\text{t-value}=\frac{\bar{x}_a-\bar{x}_b}{\frac{s}{\sqrt{n}}}\]

잘 보면, 두 공식은 매우 닮아 있습니다. 분자부분은 우리가 관심이 있는 두 값의 차이이면서 평균에 대한 것입니다. 분모부분은 약간 차이는 나지만 표준편차를 공통적으로 포함하고 있습니다. t값의 분모에 있는 \(s\)는 샘플의 표준편차입니다. 혹시라도 까먹으신 분들은 없을 것이라고 생각됩니다. 또한 t값의 분모에 있는 \(n\)은 샘플 사이즈입니다. 그럼 t값 공식을 자세히 분해해 봅시다. t-test에서 우리의 핵심 관심사는 두 그룹의 평균값의 차이입니다. 두 샘플의 평균값의 차이가 분명히 분자에 있습니다. 그러나 우리가 앞서 이야기 했듯이 이것 만으로는 도통 이 값이 큰지 작은지 알 수 없습니다. 그래서 우리는 표준편차 \(s\)를 가져와서 나누어 비율로 만듭니다. 물론 표준편차 s를 \(\sqrt{n}\)으로 나누기는 합니다만 이 부분은 뒤에서 다시 살펴보겠습니다. 다시 한번 이 t값 공식에 대해 정리하겠습니다.

- 두 그룹의 평균값의 차이는 우리의 핵심 관심사이다

- 두 그룹의 평균값의 차이를 분자에 둔다

- 그러나 이 값만으로는 충분히 큰지 작은지 알 수 없다

- 그래서 비교대상인 표준편차를 가져와 분모에 넣고 나누어 비율을 만든다

- 표준편차는 의미 없는 무작위의(random) 편차이다

- 그러므로, 평균값의 차이가 표준편차보다 작거나 비슷하다면 이 평균값의 차이는 우연히 발생했다고 판단한다

- 반대로 평균값의 차이가 표준편차보다 충분히 크다면 이 평균값의 차이는 우연히 발생하지 않았다고 보고 무엇인가 원인 혹은 이유가 있다고 추정한다

이 프로세스가 바로 t-test입니다. 모든 통계책은 t값을 구하는 공식을 외우라고만 합니다. 자세한 설명은 없고 계속 문제만 풀게합니다. 그래서 학생들은 이 공식이 의미하는 바를 이해 못하고 외우다가 문제를 풀고 시험이 끝나면 바로 잊어버립니다. 이제는 억지로 외우지 마시길 바랍니다. 공식이 왜 이렇게 생겼는지 이해했으니 암기는 미뤄두셔도 괜찮습니다.

2.5.2 왜 표준편차를 샘플 사이즈로 나누나?

앞에서 t값을 구하는 공식에 표준편차 s를 \(\sqrt{n}\)으로 나눠주는 부분이 있었습니다. 왜 그럴까요? 일단 우리는 한 가지 알아 둬야 할 것이 있습니다. 우리가 사용한 데이터는 모집단이 아닌 샘플이라는 사실입니다. 조금 철학적인 접근을 해보겠습니다. 우리는 어떤 데이터이든 사실 모집단 데이터를 이용해 분석하고 싶은 욕망이 있습니다. 왜냐하면 이렇게 모집단 데이터로 분석을 하는 것이 가장 정확할 것이기 때문입니다. 그러나 앞서 이야기 했듯이 모집단의 데이터를 모으는 것은 엄청난 시간과 노력을 요구합니다. 그래서 우리는 모집단의 부분이면서 모집단의 특성을 잘 나타낼 수 있는 샘플을 만들어서 샘플 데이터를 분석합니다. 그런데 여기서 우리는 가장 기본적이면서 중요한 대표값인 평균과 표준편차에 대해 의문을 갖게 됩니다. 샘플의 평균과 표준편차와 모집단의 평균과 표준편차는 과연 잘 맞을까? 일치할까? 라는 것입니다. 이러한 의문은 역사적으로도 있었습니다.

1920년대 미국에 대공황이 시작되자 당시의 경제학자들과 정치인들은 매우 당황했습니다. 당시에는 이제 막 경제지표에 통계적 방법이 사용되기 시작한 시기였습니다. 당시의 통계학자들은 미국의 실업률이 20%이상으로 심각한 수준이라는 경고를 했습니다. 문제는 이에 대해 당시의 대부분의 경제학자들이 이 수치를 믿을 수 없다면서 오히려 이는 대공황이 아닌 경제흐름상 사이클의 일부이며 곧 모든 것이 회복될 것이라고 주장했습니다. 그러면서 미국 전체를 대상으로 전수조사를 한 실업률이 아니고서는 믿을 수 없다고 주장하기에 이릅니다. 당연합니다. 우리는 모집단 데이터에서 평균과 표준편차의 참값을 알고 싶지만, 시간과 재정의 한계로 샘플 데이터에서 계산된 평균과 표준편차의 추정된 참값으로 분석을 진행합니다. 고민은 이 추정된 참값이 진짜 참값에 얼마나 가까운가 하는 것입니다. 그래서 이러한 고민들이 반영되어 지금 우리가 사용하는 샘플에 기반한 통계적 분석이 만들어진 것입니다.

다시 위에서 이야기한 표준편차 \(s\)를 \(\sqrt{n}\)으로 나눠주는 부분으로 돌아가 보겠습니다. 기본적으로는 그렇습니다. 우리의 표준편차 \(s\)는 샘플의 표준편차입니다. 또한 우리의 샘플은 모집단의 일부이고 그래서 샘플 사이즈 (\(n\))은 다양할 수 있습니다. 샘플 사이즈가 n=100 일수도 있고, n=1,000,000일수도 있습니다. 학자들이 살펴보니 샘플 사이즈에 따라서 표준편차가 크게 영향을 받는 것을 발견하였습니다. 실제로 샘플 사이즈가 커질 수록 샘플의 표준편차는 점점 작아집니다. 이는 단순히 작아지는 것이 아니고 사실은 모집단의 표준편차인 \(\sigma\)에 가깝게 접근하는 것입니다. 그래서 위의 t값을 계산하는 공식에서 단순히 표준편차 \(s\)가 아닌 여기에 샘플 사이즈를 감안해 보다 정확한 수치로 보정해주는 것입니다. 사실 이러한 설명은 정통 통계학적으로 맞다고 하기 어렵지만 우리 수준에서는 일단 이정도로 알고 지나가면 되겠습니다.

2.5.3 자유도 (degree of freedom)

사실 앞에서 보았던 t값의 공식은 거기서 끝이 아닙니다. 한가지 더 있습니다. 공식이 하나 더 있다기 보다는 공식에 관련된 개념이 하나 새로 등장합니다. 그것이 바로 자유도, 영어로는 degree of freedom입니다. 참으로 난감하지 않을 수가 없습니다. 이름이 자유도라니 이 무슨 난리일까요?

\[\text{t-value}=\frac{\bar{x}_a-\bar{x}_b}{\frac{s}{\sqrt{n}}} \quad \quad \quad _{(df=n-1)}\]

t값 공식 뒤에 \(df = n-1\) 이라는 것이 있습니다. 여기서 df가 바로 degree of freedom의 약자인 자유도입니다. 일단 이 \(df = n -1\) 이라는 공식에 집중해 보겠습니다. 자유도는 샘플 사이즈에서 1을 뺀 것이라는 의미입니다. 그러므로 샘플 사이즈가 커지면 자유도가 커지고, 샘플 사이즈가 작아지면 자유도가 작아진다는 의미가 됩니다. 이를 좀 다르게 해석해보면, 샘플 사이즈가 커지면 더 자유로워지고, 샘플 사이즈가 작아지면 덜 자유로워진다고 할 수 있습니다. 과연 더 자유로운 것은 무엇이고 덜 자유로운 것은 무엇일까요? 통계에서 자유롭다는 것은 앞에서 본 정규분포를 따르는 경우를 의미합니다. 왜냐하면 정규분포를 따르면 이미 많은 것이 계산되어 있어서 우리가 그다지 힘들여 무엇인가를 할 필요가 없기 때문입니다.

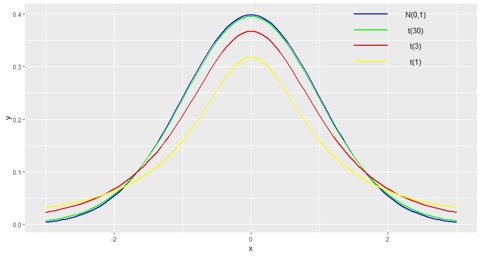

이러한 패턴을 Figure 2.17 을 통해서도 알 수 있습니다. 여기서 노란색의 분포곡선은 자유도가 1일 때의 t분포곡선입니다. 자유도가 1이라면 샘플 사이즈는 2개일 것입니다. 여기서 샘플 사이즈를 늘려 자유도가 3인 붉은색의 t분포곡선이 그 위쪽에 존재하고 전보다 좀 더 뾰족해지고 좌우로 퍼져있는 편차가 줄어들어 보입니다. 여기서 샘플 사이즈를 더 늘려서 자유도가 30인 t분포곡선을 초록색으로 그리면 이 t분포곡선이 파란색의 표준정규분포와 거의 비슷해 지는 것을 볼 수 있습니다. 그러므로 샘플사이즈가 커져서 자유도가 증가하면 할수록 t분포곡선은 표준 정규분포곡선을 향해 움직이게 된다는 의미입니다. 이는 어쩌면 당연한 것인데, 우리가 샘플 사이즈를 계속 늘리다보면 언젠가는 모집단에 이르게 될 것이기 때문입니다. 그러므로 샘플 사이즈가 커질 수록 우리가 가진 t분포곡선은 표준 정규분포곡선처럼 되는 것입니다. 다시 강조하자면 샘플 사이즈가 커진다는 것은 자유도가 커져 보다 자유롭다는 것인데 이는 우리의 t분포곡선이 표준 정규분포곡선에 접근할수록 우리의 통계가 보다 자유로워진다는 의미로 사용된다고 보시면 됩니다.

2.5.4 본격적인 t-test를 해보자

여태까지 공부한 것을 모두 정리해서 t-test를 진행해 보겠습니다. 잊지말고 Figure 2.4 의 그림을 떠 올리며 다시 정리해 봅시다.

\[\text{t-value}=\frac{\bar{x}_a-\bar{x}_b}{\frac{s}{\sqrt{n}}} \quad \quad \quad _{(df=n-1)}\]

A대학 남학생의 평균키는 178.5cm, B대학 남학생의 평균키는 179.9cm였으며 우리는 이제 이를 바탕으로 t값을 구하고자 합니다. 이제 우리에게 필요한 정보는 \(s\)와 \(n\)입니다. 여기서 표준편차 \(s\)를 7.05cm 라고 하고, 샘플 사이즈 \(n\)이 101명이었다고 가정하겠습니다. 다시 한 번 말씀드리지만 어디서 어떻게 이런 표준편차와 샘플 사이즈가 계산되었냐는 여기서는 중요하지 않습니다. 왜냐하면 지금 우리는 t-test의 기초를 이해하는 과정이기 때문에 세부적인 계산방법은 추후에 다루겠습니다. 솔직히, 시험을 제외하고는 이런 계산을 직접할 일이 없기 때문에 저는 공식에 집착하는 것이 매우 불필요하고 무용하다고 생각합니다. 미국에서도 시험때는 한 장의 종이에 필요한 공식을 써서 시험장에 가지고 들어갈 수 있었습니다. 그러니 굳이 쓸데없이 공식을 암기하는데 시간을 낭비할 필요가 없었습니다. 그럼 계산해 보겠습니다.

\[\text{t-value}=\frac{\bar{x}_a-\bar{x}_b}{\frac{s}{\sqrt{n}}}=\frac{_{178.5-179.9}}{\frac{7.05}{101}} \approx -1.996\]

이 계산을 통해 구한 t값은 -1.996입니다. 우리는 앞에서 이야기 했듯이 양측검정을 할 것이라서 t값이 1.996보다 큰 부분의 면적과 t값이 -1.996보다 작은 면적 양쪽의 면적의 합을 p값으로 사용할 것입니다. 이게 무슨 뜻인지 잘 이해가 되지 않으신다면 분자의 빼는 순서를 바꾸면 이해가 되실 것입니다.

\[\text{t-value}=\frac{\bar{x}_a-\bar{x}_b}{\frac{s}{\sqrt{n}}}=\frac{_{179.9-178.5}}{\frac{7.05}{101}} \approx 1.996\]

그렇다면 이제 이 면적을 어떻게 구해야 할까요? 물론 적분을 하면 됩니다만 우리는 앞에서 적분을 하지 않고도 p값을 구하는 방법을 z-test에서 배웠습니다. 앞에서는 z값을 구한다음 z-table (표준 정규분포표)를 이용해 적분 없이 p값을 구했습니다. 그렇다면 t-test에 t값이 있었다면 당연히 t-table이 있어야 하지 않을까요? 맞습니다. 우리는 t-table을 이용할 것입니다. 이 또한 통계학자들이 친절하게도 미리 만들어서 우리의 모든 통계 교과서 뒤쪽에 부록으로 넣어두었습니다. 필요하다면 인터넷에서 검색해도 됩니다.

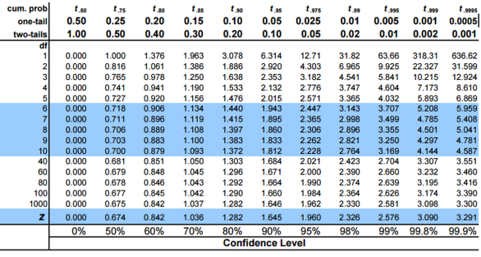

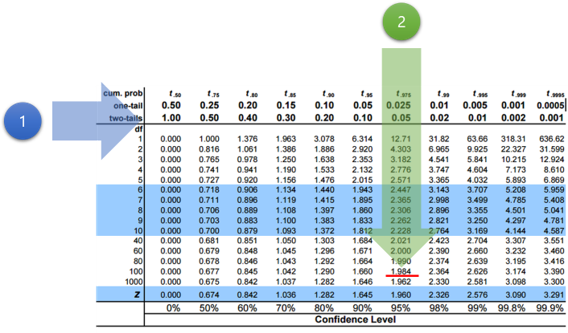

Figure 2.18 은 t-table을 짧게 축약한 것입니다. 가장 상단의 첫번째 행을 자세히 보면 첫번째 줄에 cum. prob라고 되어 있습니다. 이는 cumulative probability의 약자로 누적확률이라고 보시면 됩니다. 이 누적확률 우측으로는 t.50 t.75 t.95 t.975 등이 있습니다. 이는 t분포에서 단측검정 기준으로 \(1-\alpha\)의 값을 의미합니다. 즉, t.975 는 t분포의 좌측 끝에서부터 우측의 어느 t값까지의 총 면적이 97.5%가 되는 t값을 의미합니다. 어렵죠? 여기서 α는 앞에서 살펴보았던 1종오류의 그 \(\alpha\)입니다. 우리는 유의수준 \(\alpha\)라고도 부릅니다. 즉 우리가 항상 말하는 5% (0.05)가 바로 이 \(\alpha\)입니다. 이 부분이 좀 복잡하다면 보다 쉽게 보기 위해 cum. prob 아래에 one-tail과 two-tails가 있습니다. 여기서 one-tail은 단측검정을, two-tails는 양측검정을 의미합니다. 그리고 우측에는 우리가 원하는 \(\alpha\) 값을 적어 놓았습니다. 우리는 앞서 양측검정을 하기로 했습니다. 그리고 당연히 우리의 유의수준 \(\alpha\)는 0.05입니다. 이 값에 맞는 열을 찾으면 됩니다. 그리고나서 좌측의 첫번째 열을 보면 one-tail과 two-tails 아래에 df가 있습니다. 자유도 입니다. 우리의 샘플 사이즈는 101이므로 자유도 \(df = 101- 1 = 100\)이 됩니다. 그러면 여기에 해당하는 행을 찾아서 맞춰보면 됩니다.

t-table에서 이 방법으로 값을 찾아보면 1.984라는 값이 나옵니다. 이 값은 앞에서 설명한 c.v. (critical value)로서 이 값은 일종의 임계치로 이 값보다 커야만 p값이 \(\alpha\) 보다 작아진다는 의미가 됩니다. 여기서는 t값의 c.v.가 1.984이고 \(\alpha\)는 0.05였으며, 우리가 구한 t값은 1.996이었기 때문에 우리의 t값이 c.v.보다 크므로 우리의 p값은 5%보다 작아지므로 우리는 귀무가설을 기각하고 대립가설을 채택하게 되어, 두 대학의 남학생의 평균키의 차이 1.4cm는 우연히 발생한 것이 아니라는 결론을 내리게 됩니다.

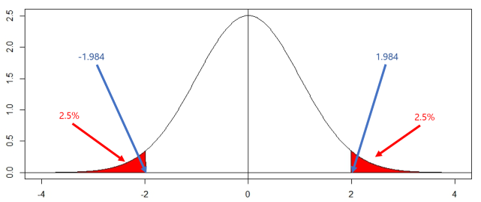

여러분들의 이해를 돕기위해 t분포곡선 상에서 어떻게 되는 것인지 보겠습니다. Figure 2.20 을 보면 양쪽의 붉은 면적이 바로 유의수준 \(\alpha\) 입니다. \(\alpha\)는 5% (0.05)이지만 우리는 양측검정을 하기로 했으므로 이를 둘로 나누어 각 2.5%씩 두개의 붉은 면적이 5%의 확률이 됩니다. 이때 이 면적이 x축과 닿는 지점이 바로 c.v.가 되는데 이때의 t값은 1.984라는 것입니다. 즉, t값이 1.984가 되면 정확히 p값은 5% (0.05)가 된다는 의미입니다. 따라서 만약 우리의 t값이 1.984 보다 크다면 (혹은 -1.984 보다 작다면), 면적이 지금보다 더 작아질 것이므로 우리의 p값은 5%보다 작아집니다. 반면에 만약 t값이 1.984 보다 작다면 (혹은 -1.984 보다 크다면), 면적이 지금보다 더 커지게 되어 p값은 5%보다 커지게 됩니다.

2.5.5 t-test의 해석과 결론

사실 통계 프로그램을 사용하면 이러한 복잡한 계산을 직접할 일이 없습니다. 문제는 그러다 보니 많은 사람들이 사용하기 쉬운 통계 프로그램에 데이터만 넣고 무작정 돌린 후에 p값이 5% 보다 큰지 작은지만 확인하고 해석 또한 별도의 말 없이 “p값이 0.05보다 작으니 유의하다”라는 말로 끝내는 경우를 많이 봅니다. 솔직히 이는 통계분석을 하긴 했는데, 무슨 뜻인지는 모르겠으니 무작정 유의하다라고 하는 것입니다. 제가 가장 경계하는 것이 그냥 무작정 유의하다라는 말을 반복하는 것입니다. 유의하다면 이게 그래서 무슨 뜻인지 해석을 해야하는데, 그런 해석이 없는 것이지요. 정리해 보면 이렇습니다.

- A대학 남학생의 평균키는 178.5cm, B대학 남학생의 평균키는 179.9cm 이다.

- 표준편차 s는 7.05cm 이고, 샘플 사이즈 n은 101명이다.

- t값의 공식을 이용해 구한 t값은 1.996이다.

- t-table에서 양측검정 (two-tails)의 유의수준 \(\alpha\) = 0.05와 \(df = 101 - 1 = 100\)을 이용해 찾은 c.v.은 1.984이다.

- 우리의 t값이 c.v. 보다 크므로 p값은 5% (0.05)보다 작아 유의하다.

- 그러므로 우리는 귀무가설을 기각하고 대립가설을 채택하기로 한다.

- 이는 두 대학의 평균키 차이 1.4cm가 우연히 발생하지 않았으며, 여기에는 무언가 이유 혹은 원인이 있다고 추정할 수 있다.

여기서 중요한 것은 유의하다로 끝내서는 안된다는 것입니다. 유의하므로 이 결과를 이렇게 저렇게 보아야 한다고 해석해야 합니다. 이것이 우리가 통계를 이용해 분석하는 궁극적인 목적이기 때문입니다. 단순히 유의하다 아니다가 통계의 목적이 아니라는 점을 분명히 알고 있어야 합니다.

2.6 t-test를 종류별로 알아보자

2.6.1 t-test에도 종류가 있다

사실 우리가 앞에서 t-test의 예제로 사용한 것은 정말 극단적으로 쉬운 예를 들기 위해 만든 것입니다. t-test에는 크게 세 가지 종류가 있습니다. 그리고 이 세 가지 종류의 t-test에 사용되는 t값을 구하는 공식도 또한 다릅니다. 사실 저도 공식을 외우지도 못합니다. 뿐만 아니라 때로는 공식을 봐도 계산하려면 진땀을 뺍니다. 저는 공식을 굳이 외울 필요가 없다고 생각합니다. 혹시 통계전공자라면 모르겠으나 비전공자로서 통계적 분석을 하려고 한다면 굳이 공식을 외울 필요는 없다고 봅니다. 요즘처럼 컴퓨터가 발달한 시대에 어지간한 계산은 프로그램이 다 알아서 해주는데 굳이 이걸 외워야 하나 싶습니다.

그러나 한 가지는 꼭 알아야 합니다. t-test의 종류별 특징입니다. 어떤 상황에서 무엇을 목적으로 할 때 이런 종류의 t-test를 사용해야 한다는 점은 분명히 알아야 합니다. 만약 이를 헷갈리면 엉뚱한 방법을 적용해서 분석을 하게되고 당연히 결과도 문제가 되기 때문입니다. 그러면 이제 t-test의 종류에 대해 알아보겠습니다.

2.6.2 Two-sample t-test

여기서 주의할 점은 통계 프로그램마다 이름이 조금씩 다를 수 있다는 것입니다. 어떤 프로그램에서는 이를 independent t-test라고 부르기도 합니다. 기본적으로 이 t-test는 두 개의 독립적인 샘플을 대상으로 두 샘플이 동일한지 아닌지에 대한 분석을합니다. 만약 두 샘플이 동일한 모집단에서 나온 것이라면 동일 할 것이고, 서로 다른 모집단에서 나온 것이라면 다를 것이라는 생각에서 분석을 합니다. 우리가 앞에서 보았던 두 대학의 남학생의 평균키의 차이를 알고자 할 때 사용하는 방법입니다(Figure 2.4).

\[\text{t-value}=\frac{\bar{x}_a-\bar{x}_b}{\sqrt{\frac{s^2}{n_a}+\frac{s^2}{n_b}}} \quad (_{s^2}=\frac{\sum(x_a-\bar{x}_a)^2+\sum(x_b-\bar{x}_b)^2}{n_a+n_b-2})\]

실제로 two-sample t-test의 t값 공식은 꽤 복잡합니다. 앞에서 우리는 쉽게 설명하기 위해 단순화한 것입니다. 여기서 자유도 \(df\) 는 \(n_a+n_b-2\) 가 됩니다. 그리고 여기서 \(n_a\) 는 A대학의 샘플 사이즈이고 \(n_b\) 는 B대학의 샘플 사이즈입니다. 저도 기억에 이 계산은 학생 때 시험에서 한번인가 해본 것 같습니다. 절대 외우실 필요는 없다고 봅니다.

2.6.3 One-sample t-test

이 t-test는 이름과 같이 샘플이 한 개인 경우에 하는 t-test입니다. 이 경우 샘플은 한 개인데 이 샘플의 평균값이 우리가 알고 있는 어떤 값과 동일한지 아닌지 알고 싶을 때 하는 방법입니다. 예를 들어 설명해 보겠습니다.

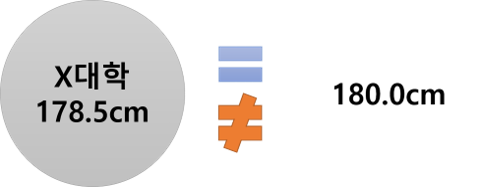

어느 대학교 X의 남학생의 평균키가 178.5cm였습니다. 금년도 정부 발표에 의하면 우리나라 20대 남성의 평균키가 180.0cm라고 합니다. 그래서 우리는 X대학 남학생 샘플의 평균키가 180.0cm와 같은지 아닌지 알고 싶습니다. 이런 경우 실시하는 것이 바로 one-sample t-test입니다.

\[\text{t-value}=\frac{\bar{x}_a-\bar{x}_b}{\frac{s}{\sqrt{n}}} \quad \quad \quad _{(df=n-1)}\]

사실 우리가 앞의 예제에서 사용했던 식입니다. 앞에서는 설명의 용이성을 위해 two-sample t-test의 예에 one-sample t-test의 공식을 썼던 것입니다. 이제는 우리가 차이를 알았으니 이게 맞는 것이구나 하고 생각하면 됩니다. 두 방식의 공식은 매우 달라 보이지만 근본적인 원리는 동일하기 때문에 크게 고민할 필요가 없습니다.

2.6.4 Paired t-test

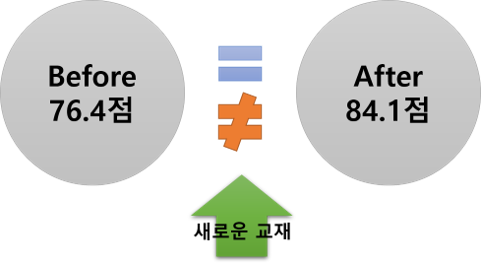

이 방법은 독특하게 paired라는 이름이 붙어 있습니다. 영어의 paired는 짝 지어진 이란 뜻으로 통계에서는 반복측정의 경우 paired 라는 단어를 주로 사용합니다. 반복측정이란 동일한 대상에게 다른 시점에 복수로 측정하는 것을 의미합니다. 다만 우리는 t-test이므로 딱 2회 측정한 것입니다. 예를 들어보겠습니다. 어느 통계 강의에서 중간고사까지는 기존의 강의교재를 이용하여 수업을 진행하다가 중간고사 이후 기말고사까지는 새로운 강의교재를 사용하여 수업을 진행하였습니다. 이때 새로운 강의교재가 사용되기 이전과 이후의 시험점수를 비교하였습니다. 해당 강의를 수강한 학생은 동일하며 모든 학생이 다른 강의교재로 수강하고 2회 시험을 보았습니다.

우리가 궁금한 것은 새로운 교재로 강의를 한 것이 학생들의 실력향상에 도움이 되었는지 아닌지 입니다. 그러므로 동일한 학생들이 2회 시험을 보았고 새로운 교재를 사용하기 전과 후의 시험점수를 비교하고자 합니다. 이런 경우에 사용하는 것이 바로 paired t-test 입니다.

\[\text{t-value}=\frac{\bar{x}_{diff}}{\frac{s_{diff}}{\sqrt{n}}} \quad \quad \quad _{(df=n-1)}\]

여기서 작은 글자로 diff라고 되어 있는 것은 차이 (difference)를 의미합니다. 즉 분자에는 동일 학생의 두 번의 점수의 차이값의 평균이고, 분모에 들어가는 것은 이 차이의 표준편차입니다.

축하합니다!

여러분들은 지금 통계학에서 만나는 첫번째 통계분석 방법을 마스터했습니다.

여기까지 오느라 수고 많이 하셨습니다. 사실 t-test는 무작정 공식을 암기하는 그런 것이 아니었습니다. 매우 논리적이며 이 논리에는 여러 이야기들이 숨어 있었습니다. 우리는 그중에서도 통계는 분산의 마법이라는 것을 확인할 수 있었고 이제 비로소 보다 깊은 통계의 세계로 들어갈 준비를 마쳤습니다. 다시 한 번 말씀드리지만 공식을 암기하는 것은 바보같은 일입니다. 계산은 컴퓨터 프로그램이 알아서 해줄 것입니다. 다만 우리는 어떤 경우에 어떤 방법을 적용할 것이지 알고 있어야 합니다. 이제 이론적으로 t-test를 마스터 했으니 실제 프로그램을 이용해서 실습을 진행해 봅시다.

2.7 t-test를 실습해 보자

2.7.1 통계프로그램의 선택

이제 우리는 컴퓨터 프로그램을 이용해 t-test 실습을 해 보겠습니다. 어떤 프로그램을 사용해야 할 까요? 가르치는 사람 입장에서 가장 난감한 것이 바로 이 문제입니다. 전 세계적으로 일반인들이 가장 애용하는 역사와 전통을 자랑하는 프로그램은 바로 SPSS입니다. 그러나 이것 말고도 다양한 통계 프로그램이 있습니다. SAS, STATA, R 등이 그것입니다. 이 중에서 어떤 것으로 실습 하는 것이 좋을까요? 사실 무엇이든 상관없습니다. 특히 통계의 기초적인 수준에서는 아무 관계가 없습니다. 문제는 비용입니다. 대부분의 통계 프로그램들은 돈을 주고 라이선스를 사야만 합니다. 최근에는 R과 같은 오픈소스 프로그램이 등장하여 큰 바람을 일으키고 있기도 합니다. 먼저 대표적인 통계 프로그램을 비교해 보겠습니다.

- SAS

- 사용 편의성: 낮음

- 배움의 용이성: 매우 낮음

- 통계기초에는 문제가 없으나 고급방법론으로 갈수록 복잡

- 비용: 매우 높음

- SPSS

- 사용 편의성: 높음

- 배움의 용이성: 매우 높음

- 통계기초에는 문제가 없으나 고급방법론으로 갈수록 매우 복잡

- 비용: 매우 높음

- STATA

- 사용 편의성: 높음

- 배움의 용이성: 높음

- 통계기초 + 고급방법론 모두를 상당히 쉽게 사용할 수 있음

- 비용: 매우 높음

- R

- 사용 편의성: 매우 낮음

- 배움의 용이성: 매우 매우 낮음

- 통계기초 + 최신 고급방법론까지 모두 제공/업데이트

- 비용: 무료

제가 처음 통계를 가르칠 때 가장 고민한 문제가 바로 프로그램의 선택이었습니다.

SAS는 약간의 프로그래밍 느낌이 있어서 초보자들은 데이터를 불러오는 것만으로도 어려움을 느껴 포기하는 프로그램입니다. 다만 어느 정도의 프로그래밍이 가능하다면 데이터를 자유롭게 가공하여 분석할 수 있으며 필요에 따라 내가 원하는 분석방법을 만들어서 사용할 수도 있습니다. 그렇지만 배우기 정말 어려운 프로그램입니다. 저도 미국에서 석사학생 시절에 SAS를 사용했었는데 참 고생했던 기억이 납니다. 다음은 가장 많이 사용하는 SPSS입니다. GUI (Graphical User Interface)가 워낙 잘 되어 있는 프로그램이어서 클릭만으로 통계분석이 가능한 프로그램입니다. 더구나 굉장히 많은 통계 책들이 SPSS 사용법을 친절하게 알려주고 있어서 통계를 잘 모르더라도 책을 통해 클릭하면서 따라가다 보면 통계분석을 할 수 있는 장점이 있습니다. 제가 학부생 시절에 조금 사용해 본 경험이 있습니다. 워낙 쓰기 쉬워서 약간의 센스만 있어도 사용할 수 있습니다. 세번째는 STATA입니다. 비교적 최근에 등장하여 성장한 프로그램입니다. SAS적인 특성과 SPSS적인 특성 모두가 반영되어 필요에 따라서는 명령어를 타이핑하여 실행할 수도 있으며 이것이 어렵다면 SPSS처럼 GUI를 이용하여 클릭만으로 통계 분석을 진행할 수 있습니다. 가장 큰 장점은 SAS나 SPSS에 비해 최신의 방법론이 빠르게 업데이트되고 있다는 점입니다. 그래서 저는 박사학생 시절부터는 STATA를 사용해 왔습니다. 마지막은 R이라는 프로그램인데요. 사용 편의성이 낮고 배우기에 너무 어려운 프로그램입니다. 그러나 전 세계의 전문가 그룹이 최신의 방법들을 패키지로 만들어 계속 업데이트 하고 있어 발전속도가 매우 빠른 프로그램입니다. 최근에는 R의 사용 편의성 개선을 위해 R을 인스톨 한 후에 RStudio라는 프로그램을 인스톨하면 기존의 R보다는 보다 사용하기 편리한 환경에서 통계분석을 할 수 있게 되었습니다. 지속적인 RStudio의 발전이 일반인에게는 큰 희망이 되는 상황입니다. 그러나 SPSS와 같은 프로그램에 비하면 여전히 사용하기 어려운 프로그램입니다. 문제는 SAS, SPSS, STATA 모두 유료 프로그램인데 반해 R만 무료라는 점입니다. 제가 고민하는 부분이 이 지점입니다. 만약 제가 유료 프로그램으로 실습을 하면 여러분들이 모두 돈을 지불하고 유료 프로그램을 구입해야 하는데 쉽지 않은 결정입니다. 그래서 전 세계의 많은 사람들이 어둠의 경로를 통해 이 프로그램들을 다운받아 사용하고 있는 것이 현실입니다. 만약 제가 유료 프로그램을 사용하면 현실적으로 여러분들을 범죄의 길로 인도하는 상황이 되어 고민이 많았습니다.

2.7.2 Jamovi의 사용

그래서 수 년간 여러 프로그램들을 찾아 오던 끝에 몇 년 전에 Jamovi라는 프로그램을 알게 되었습니다. 일단, 이 프로그램의 장점은 오픈소스이기에 무료라는 점입니다. 더불어 SPSS처럼 GUI가 발달하여 사용편의성이 매우 높은 프로그램입니다. 심지어 편의성 측면에서는 SPSS 보다도 좋습니다. 또한 결과를 리포트하기에 용이하게 되어 있습니다. 더구나 최근 이 Jamovi는 기존의 단점을 극복하고 진정한 최고의 프로그램이 되었습니다. 기존에는 데이터에 한글이 들어갈 경우 에러가 발생 하는 문제 등이 있었지만 지금은 해결되었습니다. 물론, 메뉴의 한글화 작업이 아직 이루어지지 않아 불편할 수도 있으나 이는 충분히 극복 가능한 부분이라고 생각됩니다. 생각보다 빠르게 다양한 분석 패키지가 업데이트되고 있습니다. 이 프로그램은 R을 베이스로 작동되어 jamovi를 인스톨 하기 전에 먼저 R을 인스톨 하실 것을 권장합니다. 저는 불과 몇 년 전까지만 해도 약간의 불편함을 느꼈지만 최근에는 거의 불편함을 못 느끼고 오히려 정말 좋은 프로그램이라고 생각하고 사용합니다. 학생들에게는 무조건 이 프로그램을 권유합니다.

- R 다운로드: https://www.r-project.org/

- Jamovi 다운로드: https://www.jamovi.org/

제가 처음 강의를 시작할 때만해도 Jamovi가 아직 정식 1.0 version이 출시되기 전이었습니다. 지금은 정식 1.0 version이 출시되고 계속 업데이트 되고 있습니다. 초기의 프로그램이 멈추거나 화면이 깨지는 현상은 최근에는 거의 발생하지 않습니다. 이후에 다른 훌륭한 오픈소스 프로그램을 또 알려드릴 것이고 실습에 사용할 것입니다. 당장 사용하지 않더라도 R과 RStudio를 모두 인스톨 해 놓을 것을 추천드립니다. 언젠가 사용할 날이 올 것입니다.

2.7.3 실습에 사용할 데이터

제가 처음 이 강의를 시작 했을 때만해도 별도의 실습용 데이터 저장소를 만들지 않았습니다. 저의 게으름 때문이지요. 그러나 이제 실습용 데이터를 쉽게 다운로드 받을 수 있게 GigHub에 저장소를 만들었습니다. 원래 우리가 사용할 실습 데이터는 kaggle.com 에서 다운받은 것이었습니다.

- 실습용 데이터 다운로드: https://github.com/who4u78/Ko_stat_sample_data

- 캐글: www.kaggle.com

GitHub에서 다운받으셔도 되지만 한 번쯤 캐글에 들어가서 둘러보길 권합니다. 캐글에서 데이터 검색을 하시고 검색어를 “student alcohol consumption”으로 하신 후에 데이터셋에서 student-mat.csv 라는 파일을 다운받아 사용하시면 됩니다. 다운로드를 위해서는 로그인을 하셔야 할 것입니다. 이 데이터는 학생들의 수학성적을 모아 놓은 데이터입니다.

2.7.4 실습을 해보자

제가 유튜브 동영상 강의를 선호하는 이유가 바로 이 실습 때문입니다. 글로 실습을 설명하는 것은 참 비효율적이라는 생각이 듭니다. 책을 쓰면서 아무리 다시 생각해 보아도 글보다는 영상으로 실습을 직접 확인하는 것이 좋다고 판단됩니다. 그러니 유튜브링크로 들어가 직접 실습해 보실 것을 권해드립니다. 가장 좋은 방법은 더블 스크린 환경에서 하나의 화면에는 동영상을 띄우고 다른 화면에는 실습 프로그램을 띄워서 사용하시면 보다 편안한 환경을 구축 할 수 있습니다. 그러면 이제 실습의 세계로 들어가 봅시다!!